01.分类1

01.分片上传实战

02.通用并发处理工具类实战

03.实现一个好用接口性能压测工具类

04.超卖问题的4种解决方案,也是防止并发修改数据出错的通用方案

05.Semaphore实现接口限流实战

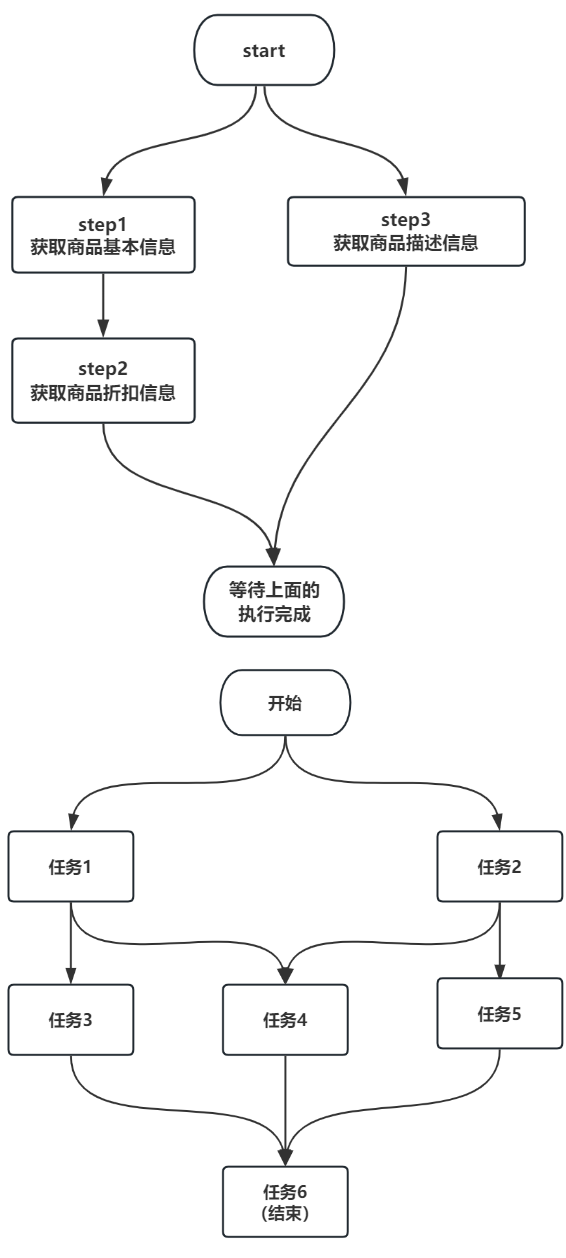

06.并行查询,优化接口响应速度实战

07.接口性能优化之大事务优化

08.通用的Excel动态导出功能实战

09.手写线程池管理器,管理&监控所有线程池

10.动态线程池

02.分类2

11.使用SpringBoot实现动态Job实战

12.幂等的4种解决方案,吃透幂等性问题

13.并行查询,性能优化利器,可能有坑

14.接口通用返回值设计与实现

15.接口太多,各种dto、vo不计其数,如何命名?

16.一个业务太复杂了,方法太多,如何传参?

17.接口报错,如何快速定位日志?

18.线程数据共享必学的3个工具类:ThreadLocal、InheritableThreadLocal、TransmittableThreadLocal

19.通过AOP统一打印请求链路日志,排错效率飞升

20.大批量任务处理常见的方案(模拟余额宝发放收益)

03.分类3

21.并发环境下,如何验证代码是否正常?

22.MySql和Redis数据一致性

23.数据脱敏优雅设计与实现

24.一行代码搞定系统操作日志

25.AOP实现MyBatis分页功能

26.ThreadLocal线程池的坑

27.读写分离实战

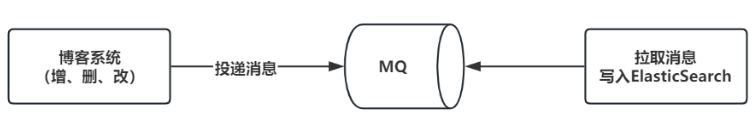

28.MQ使用场景

29.MQ确保消息的可靠性

30.MQ落地事务消息

04.分类4

41.一个注解轻松搞定分布式锁

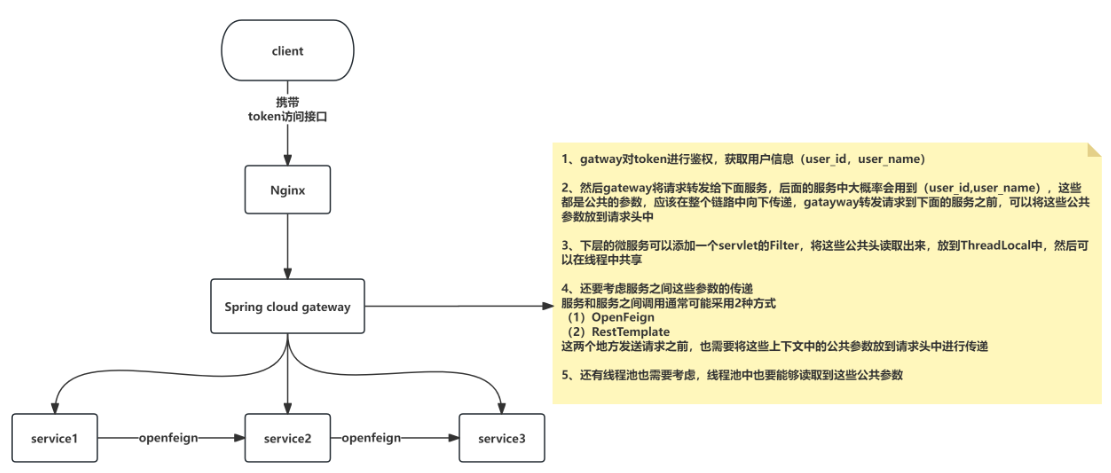

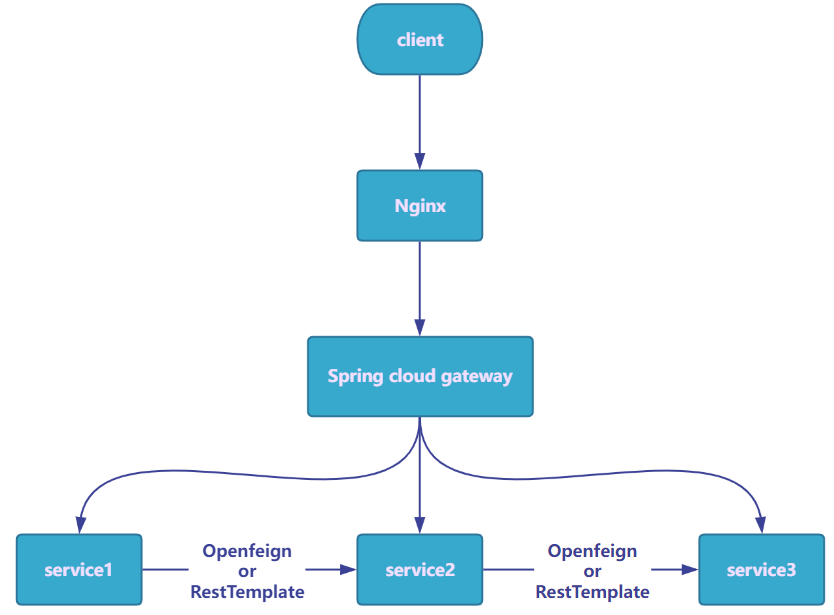

42.微服务中如何传递公共参数

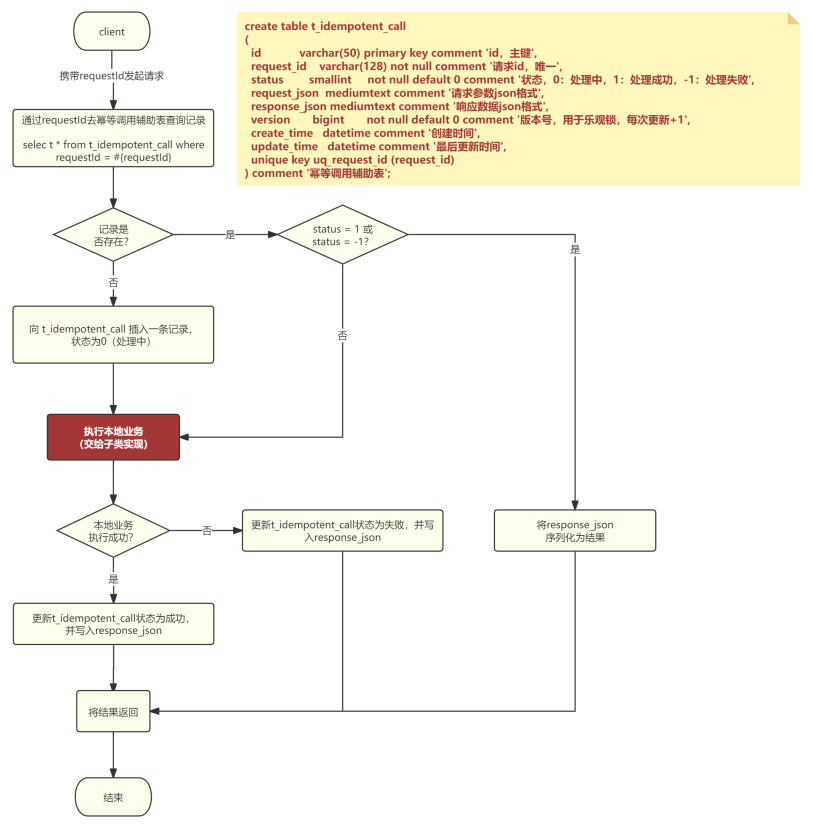

43.接口幂等的通用方案

44.微服务链路日志追踪

45.接口测试利器HTTPClient

46.MyBatis实现通用CRUD框架

47.MyBatisPlus实现多租户数据隔离

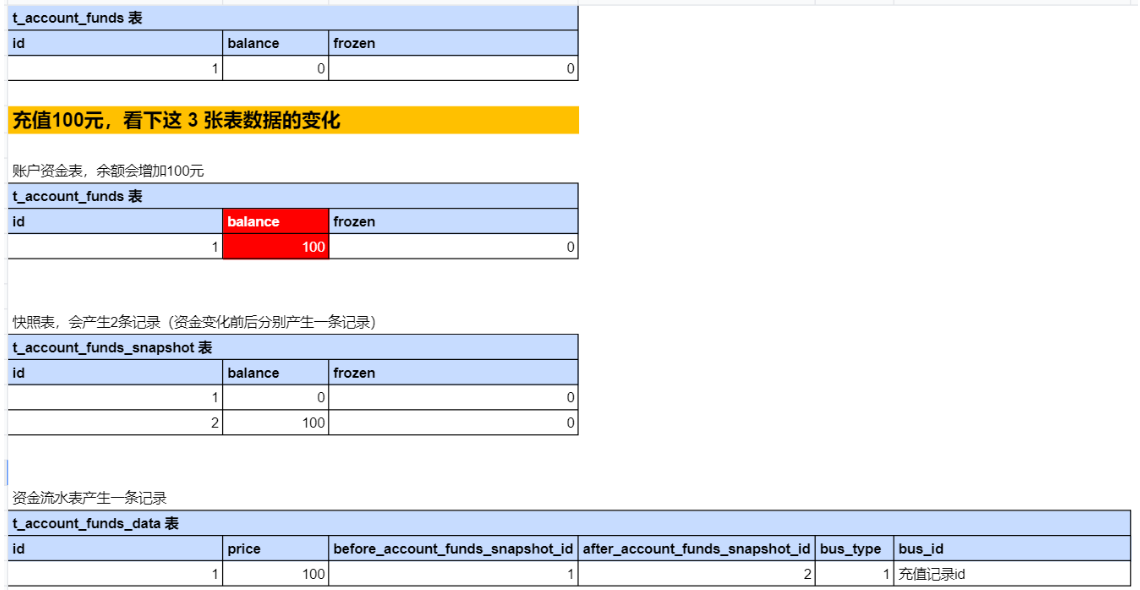

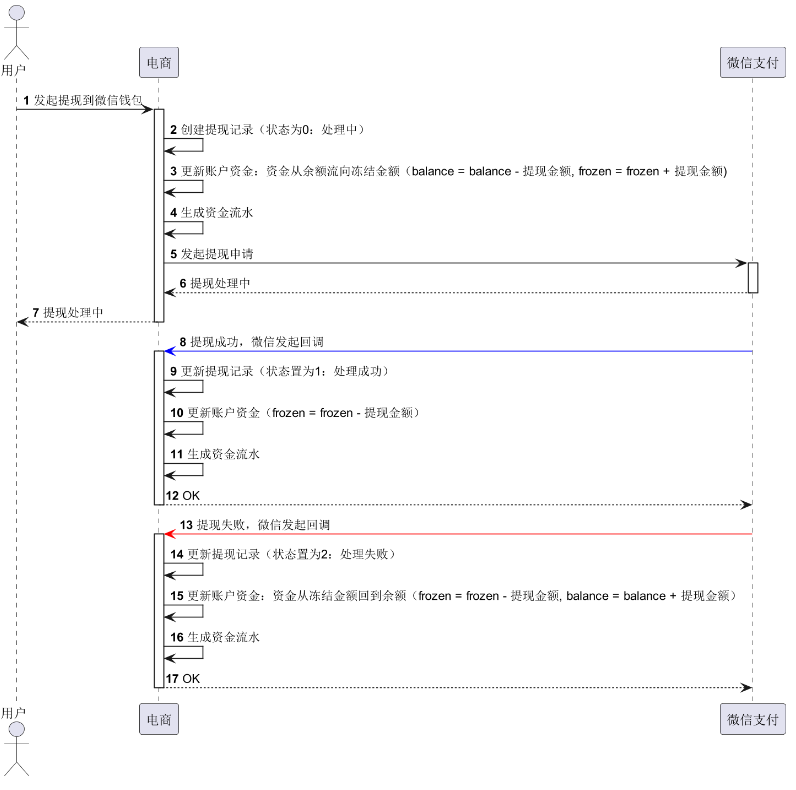

48.电商系统的资金账户表设计及实战

49.UML画图神器:PlantUML

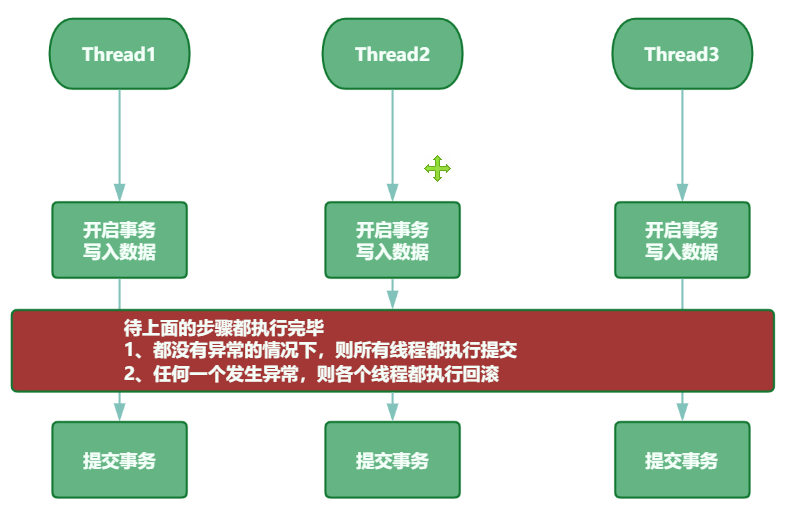

50.多线程事务,3秒插入百万数据

05.分类5

51.SpringBoot自动初始化数据库

52.SpringBoot优雅停机

53.一个特好用的集合工具类

54.性能调优:线程死锁相关问题

55.如何排查OOM

56.cpu飙升,快速排查

57.cpu升,使用Arthas,3秒定位问题

58.接口响应慢,使用Arthas,3秒定位问题代码

59.策略模式,轻松消除ifelse

60.生产上,代码未生效,如何排查?

06.分类6

61.使用MySQL,实现一个高性能,分布式id生成器

62.方法执行异常,使用arthas,快速定位问题

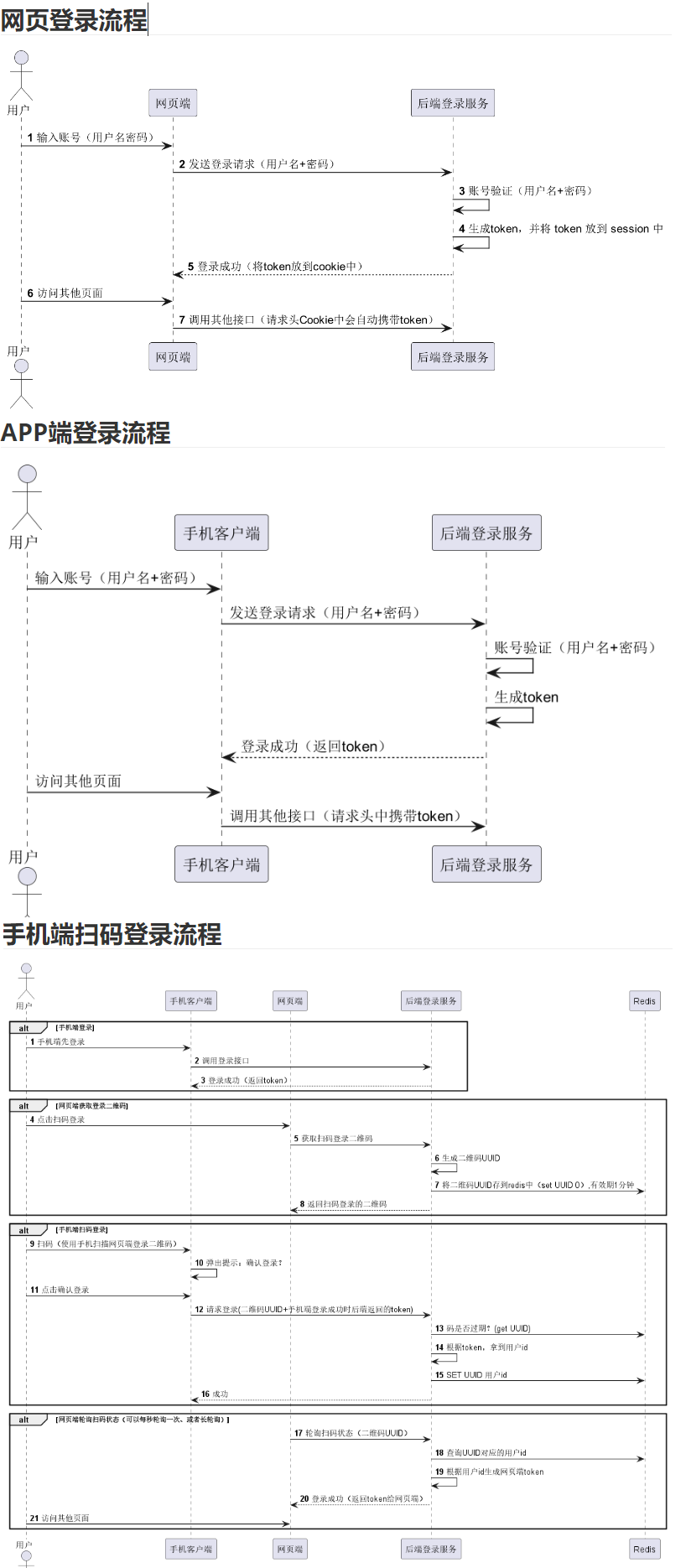

63.扫码登录

64.使用hutool生成解析二维码

65.SpringBoot中,Redis如何实现排行榜

66.SpringBoot中,Redis如何实现查找附近的人功能

67.SpringBoot中,接口签名,通用方案,一次性搞懂

68.SpringBoot中,接口加解密,通用方案实战

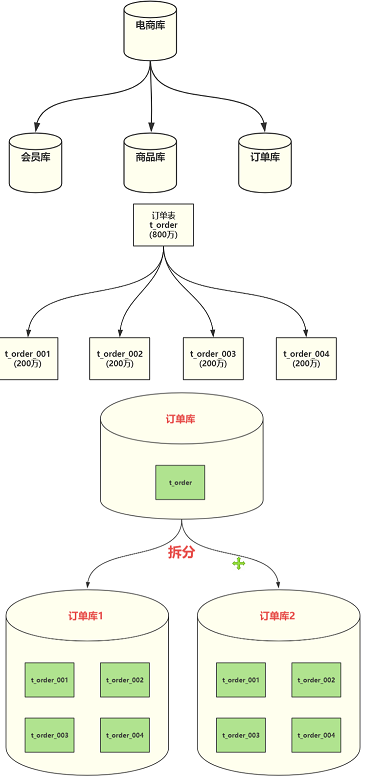

69.分库、分表、分库分表,如何选择?

70.分库分表:分表字段如何选择?

07.分类7

70.分库分表:分表字段如何选择?

71.分库分表:分表数量为什么建议是2的n次方?

72.分库分表:如何平滑迁移数据?

73.并发编程有多难?值得反复研究的一个案例

74.使用Redis Pipeline,接口性能提升10倍

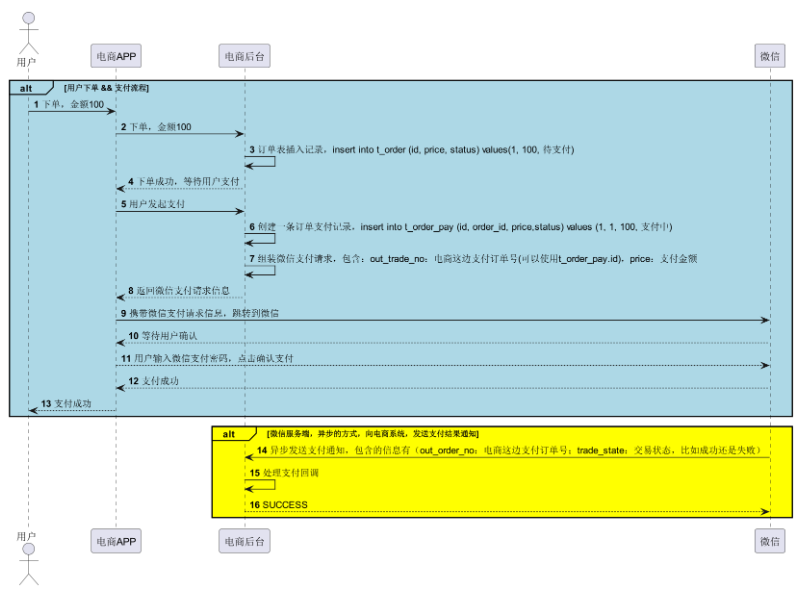

75.电商中,重复支付如何解决?

76.千万级数据,全表update的正确姿势

77.优雅实现树形菜单,适用于所有树,太好用了

78.接口调用利器:RestTemplate,吃透它

79.微服务跨库查询,如何解决?一次性搞懂

80.逻辑删除与唯一约束冲突,如何解决?

08.分类8

80.逻辑删除与唯一约束冲突,如何解决?

81.评论系统如何设计,一次性给你讲清楚

82.SpringBoot下载文件的几种方式,一次性搞懂

83.订单超时自动取消,最常见的方案

84.责任链模式优化代码,太好用了

85.CompletableFuture 实现异步任务编排,太好用了

86.idea中的必备debug技巧,高手必备

87.Java动态生成word,太强大了

88.海量据量统计,如何提升性能?

89.MyBatis模糊查询,千万不要再用${}了,容易搞出大事故

90.Spring事务失效,常见的几种场景,带你精通Spring事务

91. idea多线程调试,这个技巧也太棒了吧,你会么?

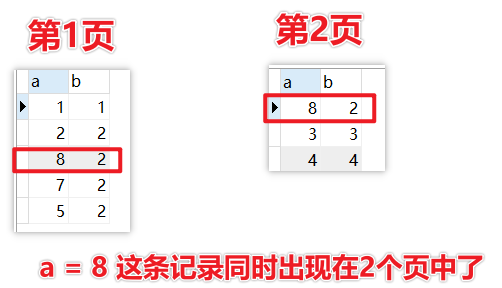

92. MySQL排序分页,可能有坑,需要注意

93. 涉及到钱的,千万不要用double,请用BigDecimal

09.分类9

90.Spring事务失效,常见的几种场景,带你精通Spring事务

91.idea多线程调试,这个技巧也太棒了吧,你会么?

92.MySQL排序分页,可能有坑,需要注意

93.涉及到钱的,千万不要用double,请用BigDecimal

94.MyBatis动态SQL不要乱用

95.MySQL数据如何同步到ES?靠谱方案

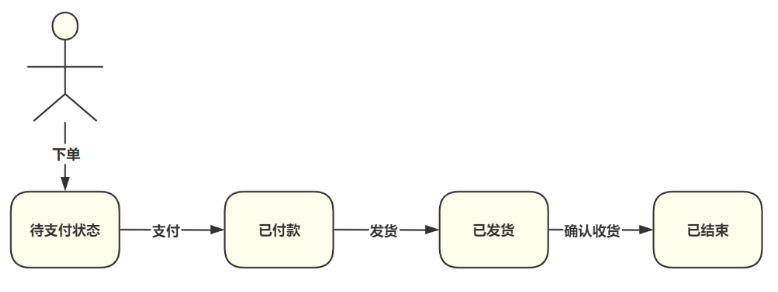

96.订单状态流转代码优化,确实优雅

97.线上问题排查思路

98.经典并发案例分析,确实有点难,一起来挑战下

99.如何优雅的处理线程池内异常?

1 part00

1.1 分片上传

01.普通上传

a.定义

调用接口一次性完成一个文件的上传

b.2个缺点

1.文件无法续传,比如上传了一个比较大的文件,中间突然断掉了,需要重来

2.大文件上传太慢

c.解决方案

分片上传

02.分片上传

a.定义

将源文件切分成很多分片,进行上传,待所有分片上传完毕之后,将所有分片合并,便可得到源文件

这里面的分片可以采用并行的方式上传,提示大文件上传的效率

b.过程

1.创建分片上传任务(分片数量、每个分片文件大小、文件md5值)

2.上传所有分片

3.待所有分片上传完成后,合并文件,便可得到源文件

c.需要用到2张表

a.分片上传任务表(t_shard_upload)

每个分片任务会在此表创建一条记录

-------------------------------------------------------------------------------------------------

create table if not exists t_shard_upload(

id varchar(32) primary key,

file_name varchar(256) not null comment '文件名称',

part_num int not null comment '分片数量',

md5 varchar(128) comment '文件md5值',

file_full_path varchar(512) comment '文件完整路径'

) comment = '分片上传任务表';

b.分片文件表(t_shard_upload_part)

这个表和上面的表是1对多的关系,用与记录每个分片的信息,比如一个文件被切分成10个分片,那么此表会产生10条记录

-------------------------------------------------------------------------------------------------

create table if not exists t_shard_upload_part(

id varchar(32) primary key,

shard_upload_id varchar(32) not null comment '分片任务id(t_shard_upload.id)',

part_order int not null comment '第几个分片,从1开始',

file_full_path varchar(512) comment '文件完整路径',

UNIQUE KEY `uq_part_order` (`shard_upload_id`,`part_order`)

) comment = '分片文件表,每个分片文件对应一条记录';

d.服务端需提供4个接口

a.创建分片上传任务

/shardUpload/init

返回分片任务id(shardUploadId),后续的3个接口均需要用到该id

b.上传分片文件

/shardUpload/uploadPart

c.合并分片、完成上传

/shardUpload/complete

d.获取分片任务详细信息

/shardUpload/detail

可以得到分片任务的状态信息,如分片任务是否上传完毕,哪些分片已上传等信息,网络出现故障,可以借助此接口恢复上传

e.上传途中出现故障如何恢复?

a.说明

比如出现网络故障,导致分片上失败,此时需要走恢复逻辑,分两种情况

b.情况1:浏览器无法读取刚才用户选择的文件了

此时需要用户重新选择文件,重新上传

这个地方也可以给大家提供另外一种思路,第1个接口创建分片任务的时候传入了文件的md5

按说这个值是具有唯一性的,那么就可以通过这个值找到刚才的任务

按照这种思路,就需要后端提供一个新的接口:

通过文件的md5值找到刚才失败的那个任务,然后继续上传未上传的分片

c.情况2:浏览器可以继续读取刚才用户选择的文件

可以先调用第4个接口,通过此接口可以知道那些分片还未上传,然后继续上传这些分片就可以了

1.2 多线程批处理工具类

01.需求

使用线程池批量发送短信,当短信发送完毕之后,方法继续向下走

02.技术点

线程池:ExecutorService

CountDownLatch:可以让一个或者多个线程等待一批任务执行完毕之后,继续向下走

03.代码实现

a.新手版

com.itsoku.SimpleBatchTask

b.高手版

com.itsoku.TaskDisposeUtils

-----------------------------------------------------------------------------------------------------

重点在于下面2行代码,简化了很多

ExecutorService executorService = Executors.newFixedThreadPool(10);

//调用工具类批处理任务

TaskDisposeUtils.dispose(taskList, TaskDisposeUtils::disposeTask, executorService);

1.3 接口性能压测工具类

01.常用的好用的压测工具

1.Apache服务器安装目录的ab.exe

2.Jmeter

3.LoadRunner

02.为什么要自己实现一个压测工具?

高并发有很多知识点

工具类,如:线程池、JUC四个常用工具类【CountDownLatch、CyclicBarrier、Semaphore、ExChange】等

03.涉及的知识点

1.线程池(ThreadPoolExecutor)

2.CountDownLatch

3.AtomicInteger

04.要实现的功能:写一个通用的压测工具类

a.类名

LoadRunnerUtils

b.类中定义一个通用的压测方法

方法定义如下,提供3个参数,可以对第3个参数需要执行的业务进行压测,最终将压测的结果返回。

-----------------------------------------------------------------------------------------------------

/**

* 对 command 执行压测

*

* @param requests 总请求数

* @param concurrency 并发数量

* @param command 需要执行的压测代码

* @param <T>

* @return 压测结果 {@link LoadRunnerResult}

* @throws InterruptedException

*/

public static <T> LoadRunnerResult run(int requests, int concurrency, Runnable command)

c.方法返回压测结果(LoadRunnerResult)

LoadRunnerResult 包含了压测结果,定义如下,主要有下面这些指标

-----------------------------------------------------------------------------------------------------

public static class LoadRunnerResult {

// 请求总数

private int requests;

// 并发量

private int concurrency;

// 成功请求数

private int successRequests;

// 失败请求数

private int failRequests;

// 请求总耗时(ms)

private int timeTakenForTests;

// 每秒请求数(吞吐量)

private float requestsPerSecond;

// 每个请求平均耗时(ms)

private float timePerRequest;

// 最快的请求耗时(ms)

private float fastestCostTime;

// 最慢的请求耗时(ms)

private float slowestCostTime;

}

05.2个测试案例

a.案例1:总请求1000个,并发100,压测一个简单的接口

a.接口代码如下:test1接口,很简单,没有任何逻辑,这个接口效率很高

@GetMapping("/test1")

public String test1() {

log.info("test1");

return "ok";

}

b.对应的压测用例代码

@Test

public void test1() throws InterruptedException {

//需要压测的接口地址,这里我们压测test1接口

//压测参数,总请求数量1000,并发100

int requests = 1000;

int concurrency = 100;

String url = "http://localhost:8080/test1";

System.out.println(String.format("压测接口:%s", url));

RestTemplate restTemplate = new RestTemplate();

//调用压测工具类开始压测

LoadRunnerUtils.LoadRunnerResult loadRunnerResult = LoadRunnerUtils.run(requests, concurrency, () -> {

restTemplate.getForObject(url, String.class);

});

//输出压测结果

print(loadRunnerResult);

}

c.运行test1用例,效果如下

压测接口:http://localhost:8080/test1

11:47:56 - 压测开始......

11:47:57 - 压测结束,总耗时(ms):601

-------------------------------------------------------------------------------------------------

压测结果如下:

请求总数: 1000

并发量: 100

成功请求数: 1000

失败请求数: 0

请求总耗时(ms): 601

每秒请求数(吞吐量): 1663.8936

每个请求平均耗时(ms): 0.601

最快的请求耗时(ms): 0.0

最慢的请求耗时(ms): 565.0

b.案例2:总请求1000个,并发100,压测一个耗时的接口

a.接口代码如下,test2接口,内部休眠了100毫秒,用于模拟业务耗时操作

@GetMapping("/test2")

public String test2() throws InterruptedException {

//接口中休眠100毫秒,用来模拟业务操作

TimeUnit.MILLISECONDS.sleep(100);

return "ok";

}

b.对应的压测用例代码

@Test

public void test2() throws InterruptedException {

//需要压测的接口地址,这里我们压测test2接口

//压测参数,总请求数量10000,并发100

int requests = 1000;

int concurrency = 100;

String url = "http://localhost:8080/test2";

System.out.println(String.format("压测接口:%s", url));

RestTemplate restTemplate = new RestTemplate();

//调用压测工具类开始压测

LoadRunnerUtils.LoadRunnerResult loadRunnerResult = LoadRunnerUtils.run(requests, concurrency, () -> {

restTemplate.getForObject(url, String.class);

});

//输出压测结果

print(loadRunnerResult);

}

c.运行test2用例,效果如下

压测接口:http://localhost:8080/test2

11:48:20 - 压测开始......

11:48:22 - 压测结束,总耗时(ms):1231

-------------------------------------------------------------------------------------------------

压测结果如下:

请求总数: 1000

并发量: 100

成功请求数: 1000

失败请求数: 0

请求总耗时(ms): 1231

每秒请求数(吞吐量): 812.34766

每个请求平均耗时(ms): 1.231

最快的请求耗时(ms): 100.0

最慢的请求耗时(ms): 281.0

1.4 商品超卖的4个方案

00.汇总

方案1:通过update中携带条件判断解决超卖问题 方案1,最靠谱

方案2:使用乐观锁版本号解决这个问题

方案3:对比数据修改前后是否和期望的一致

方案4:通过辅助类解决超卖问题

00.加锁排队

a.说明

本质上是需要加锁,不管是什么锁,只要让减库存的操作排队,便可解决超卖问题,核心点就是:加锁排队

同理:解决并发修改数据出错问题,最终也是靠锁解决

比如乐观锁、悲观锁,本质上都是要靠锁,让并发问题排队执行,只是这个锁的范围大小的问题

b.商品表

-- 商品表

create table if not exists t_goods

(

goods_id varchar(32) primary key comment '商品id',

goods_name varchar(256) not null comment '商品名称',

num int not null comment '库存',

version bigint default 0 comment '系统版本号'

) comment = '商品表';

01.方案1:通过update中携带条件判断解决超卖问题

a.原理

通过下面sql的执行结果,便可确保超卖问题,重点在于需要在update的where条件中加上库存扣减后不能为0

sql会返回影响行数,如果影响行数为0,表示库存不满足要求,扣减失败了,否则,扣减库存成功

b.代码

String goodsId = "商品id";

int num = "本次需要扣减的库存量";

// count表示影响行数

int count = (update t_goods set num = num - #{num} where goods_id = #{goodsId} and num - #{num} >= 0);

// count = 1,表示扣减成功,否则扣减失败

if(count==1){

//扣减库存成功

}else{

//扣减库存失败

}

c.源码

com.itsoku.lesson004.service.GoodsServiceImpl#placeOrder1

d.运行看结果

===========================解决超卖,方案1 开始执行=======================================

模拟 100 人进行抢购

抢购结束啦............

抢购前,商品库存:10

抢购后,商品库存:0

下单成功人数:10

下单失败人数:90

===========================解决超卖,方案1 执行结束=======================================

02.方案2:使用乐观锁版本号解决这个问题

a.原理

需要在库存表加一个version字段,这个version每次更新的时候需要+1,单调递增的

b.代码

String goodsId = "商品id";

int num = "本次需要扣减的库存量";

GoodsPo goods = (select * from t_goods where goods_id = #{goodsId});

// 期望数据库中该数据的version值

int expectVersion = goods.getVerion();

//乐观锁更新数据,where条件中必须带 version = #{expectVersion}

int count = update t_goods set num = num - ${num}, version = version + 1 where goods_id = #{goodsId} and version = #{expectVersion}

// count = 1,表示扣减成功,否则扣减失败

if(count==1){

//扣减库存成功

}else{

//扣减库存失败

}

c.源码

com.itsoku.lesson004.service.GoodsServiceImpl#placeOrder2

d.运行结果

===========================解决超卖,方案2 开始执行=======================================

模拟 100 人进行抢购

抢购结束啦............

抢购前,商品库存:10

抢购后,商品库存:0

下单成功人数:10

下单失败人数:90

===========================解决超卖,方案2 执行结束=======================================

03.方案3:对比数据修改前后是否和期望的一致

a.原理

这种方案虽然看起来很奇怪,但是有些业务场景中,可以解决一些问题

比如批量去修改数据,想判断批量的过程中,数据是否被修改过,可以通过这种方式判断

b.代码

String goodsId = "商品id";

int num = "本次需要扣减的库存量";

//扣减库存前,查出商品库存数量,丢到变量 beforeGoodsNum 中

GoodsPo beforeGoods = (select * from t_goods where goods_id = #{goodsId});

int beforeGoodsNum = beforeGoods.num;

// 执行扣减库存操作,条件中就只有goodsId,说明这个可能将库存扣成负数,出现超卖,继续向下看,后面的步骤将解决超卖

update t_goods set num = num - ${购买的商品数量} where goods_id = #{goodsId}

//扣减库存后,查出商品库存数量,丢到变量 afterGoodsNum 中

GoodsPo afterGoods = (select * from t_goods where goods_id = #{goodsId});

int afterGoodsNum = afterGoods.num;

// 如下判断,库存扣减前后和期望的结果是不是一致的,扣减前的数据 - 本次需要扣减的库存量 == 扣减后的数量,如果是,说明没有超卖

if(beforeGoodsNum - num == afterGoodsNum){

//扣减库存成功

}else{

//扣减库存失败

}

c.源码

com.itsoku.lesson004.service.GoodsServiceImpl#placeOrder3

d.运行结果

===========================解决超卖,方案3 开始执行=======================================

模拟 100 人进行抢购

抢购结束啦............

抢购前,商品库存:10

抢购后,商品库存:0

下单成功人数:10

下单失败人数:90

===========================解决超卖,方案3 执行结束=======================================

04.方案4:通过辅助类解决超卖问题

a.原理

需要添加一张辅助表(t_concurrency_safe)

如下,这张表需要有版本号字段,通过这张表的乐观锁,**将需要保护的业务方法包起来**,解决超卖问题

-----------------------------------------------------------------------------------------------------

create table if not exists t_concurrency_safe

(

id varchar(32) primary key comment 'id',

safe_key varchar(256) not null comment '需要保护的数据的唯一的key',

version bigint default 0 comment '系统版本号,默认为0,每次更新+1',

UNIQUE KEY `uq_safe_key` (`safe_key`)

) comment = '并发安全辅助表';

b.代码

String goodsId = "商品id";

int num = "本次需要扣减的库存量";

// 需要给保护的数据生成一个唯一的:safeKey

String safeKey = "GoodsPO:"+商品id;

// 如下:根据 safe_key 去 t_concurrency_safe 表找这条需要保护的数据

ConcurrencySafePO po = (select * from t_concurrency_safe where safe_key = #{safe_key});

// 这条数据不存在,则创建,然后写到 t_concurrency_safe 表

if(po==null){

po = new ConcurrencySafePO(#{safe_key});

// 向 t_concurrency_safe 表写入一条数据

insert into t_concurrency_safe (safe_key) values (#{safeKey});

}

// 下面执行扣减库存的操作,注意,如果用方案4,那么需要保护的数据的修改,均需要放在这个位置来保护,这块大家细品下

{

//扣减库存前,查出商品库存

GoodsPo beforeGoods = (select * from t_goods where goods_id = #{goodsId});

//判断库存是否足够

if(beforeGoods.num == 0){

//库存不足,秒杀失败

return;

}

// 执行扣减库存操作,条件中就只有goodsId,说明这个可能将库存扣成负数,出现超卖,继续向下看,后面的步骤将解决超卖

update t_goods set num = num - ${购买的商品数量} where goods_id = #{goodsId}

}

//对 ConcurrencySafePO 执行乐观锁更新

int update = update t_concurrency_safe set version = version + 1 where id = #{po.id} and version = #{po.version}

// 若update==1,说明被保护的数据,期间没有发生变化

if(update == 1){

//秒杀成功

}else{

//说明被保护的数据,期间发生变化了,下面要抛出异常,让事务回滚

throw new ConcurrencyFailException("系统繁忙,请重试");

}

c.源码

com.itsoku.lesson004.service.GoodsServiceImpl#placeOrder4

d.运行结果

===========================解决超卖,方案4 开始执行=======================================

模拟 100 人进行抢购

抢购结束啦............

抢购前,商品库存:10

抢购后,商品库存:0

下单成功人数:10

下单失败人数:90

===========================解决超卖,方案4 执行结束=======================================

1.5 Semaphore实现接口限流

00.汇总

工具类:LoadRunnerUtils

测试类:CurrentLimitTest

控制层:TestController

01.工具类:LoadRunnerUtils

@Slf4j

public class LoadRunnerUtils {

@Data

public static class LoadRunnerResult {

// 请求总数

private int requests;

// 并发量

private int concurrency;

// 成功请求数

private int successRequests;

// 失败请求数

private int failRequests;

// 请求总耗时(ms)

private int timeTakenForTests;

// 每秒请求数(吞吐量)

private float requestsPerSecond;

// 每个请求平均耗时(ms)

private float timePerRequest;

// 最快的请求耗时(ms)

private float fastestCostTime;

// 最慢的请求耗时(ms)

private float slowestCostTime;

}

/**

* 对 command 执行压测

*

* @param requests 总请求数

* @param concurrency 并发数量

* @param command 需要执行的压测代码

* @param <T>

* @return 压测结果 {@link LoadRunnerResult}

* @throws InterruptedException

*/

public static <T> LoadRunnerResult run(int requests, int concurrency, Runnable command) throws InterruptedException {

log.info("压测开始......");

//创建线程池,并将所有核心线程池都准备好

ThreadPoolExecutor poolExecutor = new ThreadPoolExecutor(concurrency, concurrency,

0L, TimeUnit.MILLISECONDS,

new LinkedBlockingQueue<Runnable>());

poolExecutor.prestartAllCoreThreads();

// 创建一个 CountDownLatch,用于阻塞当前线程池待所有请求处理完毕后,让当前线程继续向下走

CountDownLatch countDownLatch = new CountDownLatch(requests);

//成功请求数、最快耗时、最慢耗时 (这几个值涉及到并发操作,所以采用 AtomicInteger 避免并发修改导致数据错误)

AtomicInteger successRequests = new AtomicInteger(0);

AtomicInteger fastestCostTime = new AtomicInteger(Integer.MAX_VALUE);

AtomicInteger slowestCostTime = new AtomicInteger(Integer.MIN_VALUE);

long startTime = System.currentTimeMillis();

//循环中使用线程池处理被压测的方法

for (int i = 0; i < requests; i++) {

poolExecutor.execute(() -> {

try {

long requestStartTime = System.currentTimeMillis();

//执行被压测的方法

command.run();

//command执行耗时

int costTime = (int) (System.currentTimeMillis() - requestStartTime);

//请求最快耗时

setFastestCostTime(fastestCostTime, costTime);

//请求最慢耗时

setSlowestCostTimeCostTime(slowestCostTime, costTime);

//成功请求数+1

successRequests.incrementAndGet();

} catch (Exception e) {

log.error(e.getMessage());

} finally {

countDownLatch.countDown();

}

});

}

//阻塞当前线程,等到压测结束后,该方法会被唤醒,线程继续向下走

countDownLatch.await();

//关闭线程池

poolExecutor.shutdown();

long endTime = System.currentTimeMillis();

log.info("压测结束,总耗时(ms):{}", (endTime - startTime));

//组装最后的结果返回

LoadRunnerResult result = new LoadRunnerResult();

result.setRequests(requests);

result.setConcurrency(concurrency);

result.setSuccessRequests(successRequests.get());

result.setFailRequests(requests - result.getSuccessRequests());

result.setTimeTakenForTests((int) (endTime - startTime));

result.setRequestsPerSecond((float) requests * 1000f / (float) (result.getTimeTakenForTests()));

result.setTimePerRequest((float) result.getTimeTakenForTests() / (float) requests);

result.setFastestCostTime(fastestCostTime.get());

result.setSlowestCostTime(slowestCostTime.get());

return result;

}

private static void setFastestCostTime(AtomicInteger fastestCostTime, int costTime) {

while (true) {

int fsCostTime = fastestCostTime.get();

if (fsCostTime < costTime) {

break;

}

if (fastestCostTime.compareAndSet(fsCostTime, costTime)) {

break;

}

}

}

private static void setSlowestCostTimeCostTime(AtomicInteger slowestCostTime, int costTime) {

while (true) {

int slCostTime = slowestCostTime.get();

if (slCostTime > costTime) {

break;

}

if (slowestCostTime.compareAndSet(slCostTime, costTime)) {

break;

}

}

}

}

02.控制层:TestController

/**

* 使用 Semaphore 实现限流功能

* <b>description</b>: Java高并发、微服务、性能优化实战案例100讲,视频号:程序员路人,源码 & 文档 & 技术支持,请加个人微信号:itsoku <br>

* <b>time</b>:2024/3/30 21:01 <br>

* <b>author</b>:ready [email protected]

*/

@RestController

public class TestController {

/**

* Juc中的Semaphore可以实现限流功能,可以将 Semaphore 想象成停车场入口的大爷,

* 大爷手里面拥有一定数量的停车卡(也可以说是令牌),卡的数量是多少呢?就是Semaphore构造方法中指定的,如下就是50个卡,

* 车主想进去停车,先要从大爷手中拿到一张卡,出来的时候,需要还给大爷,如果拿不到卡,就不能进去停车。

* <p>

* semaphore 内部提供了获取令牌,和还令牌的一些方法

*/

private Semaphore semaphore = new Semaphore(50);

/**

* 来个案例,下面是一个下单的方法,这个方法最多只允许 50 个并发,若超过50个并发,则进来的请求,最多等待1秒,如果无法获取到令牌,则快速返回失败,请重试

*

* @return

*/

@GetMapping("/placeOrder")

public String placeOrder() throws InterruptedException {

/**

* semaphore 在上面定义的,里面有50个令牌,也就是同时可以支持50个并发请求

* 下面的代码,尝试最多等待1秒去获取令牌,获取成功,则进入下单逻辑,获取失败,则返回系统繁忙,请稍后重试

*/

boolean flag = this.semaphore.tryAcquire(1, 1L, TimeUnit.SECONDS);

// 获取到令牌,则进入下单逻辑

if (flag) {

try {

//这里休眠2秒,模拟下单的操作

TimeUnit.SECONDS.sleep(2);

return "下单成功";

} finally {

//这里一定不要漏掉了,令牌用完了,要还回去

this.semaphore.release();

}

} else {

return "系统繁忙,请稍后重试";

}

}

}

03.测试类:CurrentLimitTest

/**

* 使用 Semaphore 实现限流功能

* <b>description</b>: Java高并发、微服务、性能优化实战案例100讲,视频号:程序员路人,源码 & 文档 & 技术支持,请加个人微信号:itsoku <br>

* <b>time</b>:2024/3/30 21:01 <br>

* <b>author</b>:ready [email protected]

*/

public class CurrentLimitTest {

public static void main(String[] args) throws InterruptedException {

// 记录成功量、失败量

AtomicInteger successNum = new AtomicInteger(0);

AtomicInteger failNum = new AtomicInteger(0);

//下面模拟200个人同时下单,运行,大家看结果

RestTemplate restTemplate = new RestTemplate();

Runnable requestPlaceOrder = () -> {

String result = restTemplate.getForObject("http://localhost:8080/placeOrder", String.class);

System.out.println(result);

if ("下单成功".equals(result)) {

successNum.incrementAndGet();

} else {

failNum.incrementAndGet();

}

};

//模拟100个人同时发送100个请求,待请求结束,看成功量、失败量

LoadRunnerUtils.LoadRunnerResult loadRunnerResult = LoadRunnerUtils.run(100, 100, requestPlaceOrder);

System.out.println(loadRunnerResult);

System.out.println("下单成功数:" + successNum.get());

System.out.println("下单失败数:" + failNum.get());

}

}

1.6 接口优化之并行查询

00.汇总

当接口中,需要执行多个步骤,而多个步骤没有依赖的时候

那么可以采用线程池并行去执行这些步骤,可以大大提升接口的性能

01.需求:后端提供一个接口获取商品信息

接口传入一个商品id,需要返回商品下面这些信息,这些信息都在不同的表中,通过商品id就可以查到

商品基本信息(如商品名称、价格等基本信息)

商品描述信息(可能是富文本,放在单独的表中)

商品收藏量

商品评论量

02.常规版本实现(性能低)

a.说明

按照id一步步查询,组装结果然后返回

b.代码

com.itsoku.lesson006.GoodsController#getGoodsDetail

c.请求

http://localhost:8080/getGoodsDetail?goodsId=1

d.耗时

获取商品信息,普通版耗时:402 ms

03.高性能版本实现(性能高)

a.说明

这里面的4个查询并没有任何依赖,这些没有依赖的查询其实是可以并行查询的

那么我们可以使用线程池同时去拿这4个结果,然后等4个结果都拿到后,组装好,返回,这样效率将大大提升

b.代码

# 使用线程池对4个方法并行查询

com.itsoku.lesson006.GoodsController#getGoodsDetailNew

c.请求

http://localhost:8080/getGoodsDetailNew?goodsId=1

d.耗时

获取商品信息,使用线程池并行查询耗时:106 ms

04.并行查询可能存在的问题?

a.说明

如果上面执行并行查询用到的线程池配置不当,可能导致比较严重的性能问题

b.说明

比如将核心线程数设置为了1,而队列大小没有限制,那么所有的请求都变成串行了,会导致请求响应非常慢,出现大事故

或者核心线程数设置的比较小,比如10,而队列大小没有设置上限,那么这个线程池同时只可支持10个任务并行

其他的请求进入这个接口后都变成串行执行了,进入队列排队,从而导致接口响应特别慢

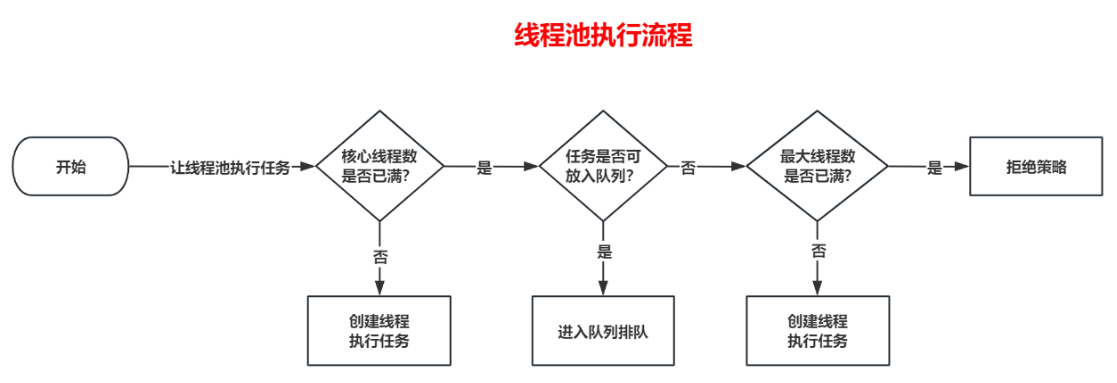

c.怎么解决这个问题?

a.说明

解决这个问题本质是不要让任务排队或者排队时间不要太长

这个时候我们就要先说一下线程池的原理了,了解原理之后,就知道如何破解这个问题

b.了解了这个过程我们就有优化办法了,如下

1.可以将核心线程数、最大线程数调大,但是也不能随便调,比如调的很大,反而会降低系统性能,建议调的过程中根据业务的指标进行压测得到一个合理的值

2.将队列大小设置的比较小,这样排队的时间大概率会比较短,或者排队失败,直接后面的流程

LinkedBlockingQueue、ArrayBlockingQueue` 容量是不允许为0的,如果需要用到容量为0的队列,则需要使用同步阻塞队列`SynchronousQueue`

3.将队列大小设置为0,这样任务就不会进入队列,而直接创建新的线程去执行,或者走拒绝策略

4.拒绝策略可以使用`CallerRunsPolicy`,这个策略是直接在当前线程执行,即如果线程池执行不了,则自己去执行,这样至少不会一直等着

5.线程池隔离,不同的业务最好使用不同的线程池,互不影响,强烈建议核心业务一定要使用单独的线程池。

c.优化后的线程池配置

@Bean

public ThreadPoolTaskExecutor goodsThreadPool() {

ThreadPoolTaskExecutor threadPoolTaskExecutor = new ThreadPoolTaskExecutor();

threadPoolTaskExecutor.setThreadNamePrefix("ThreadPool-Goods-");

// 核心线程数为cpu核数 * 4,最大线程数据为cpu核数 * 8

threadPoolTaskExecutor.setCorePoolSize(Runtime.getRuntime().availableProcessors() * 4);

threadPoolTaskExecutor.setMaxPoolSize(Runtime.getRuntime().availableProcessors() * 8);

// 队列容量为0,则任务就不会进入队列

threadPoolTaskExecutor.setQueueCapacity(0);

// 拒绝策略使用CallerRunsPolicy,让当前线程去兜底去执行任务

threadPoolTaskExecutor.setRejectedExecutionHandler(new ThreadPoolExecutor.CallerRunsPolicy());

return threadPoolTaskExecutor;

}

1.7 接口优化之大事务优化

00.汇总

1.系统性能要求很高,可以使用TransactionTemplate编程式事务,精准控制事务的粒度,尽量让事务小型化

2.尽量避免将没有事务的耗时操作放到事务代码中

3.避免在事务中执行远程操作,远程操作是不需要用到本地事务的,所以没有必要放在事务中

4.尽量让事务的操作集中在一起执行,比如都放到方法最后,使用TransactionTemplate执行,这样可使事务最小化

01.示例

a.代码

@Transactional

public void bigTransaction() throws InterruptedException {

// 1、getData()方法模拟一个比较耗时的获取数据的操作,这个方法内部会休眠5秒

String data = this.getData();

//2、将上面获取到的数据写入到db中

Lesson007PO po = new Lesson007PO();

po.setId(UUID.randomUUID().toString());

po.setData(data);

this.lesson007Mapper.insert(po);

}

public String getData() throws InterruptedException {

//休眠5秒

TimeUnit.SECONDS.sleep(5);

return UUID.randomUUID().toString();

}

b.说明

明眼人可能已经看出来了,方法上加了`@Transactional`注解,加了这个注解

说明这个方法会交给Spring来自动管理这个方法的事务,那么这个方法的逻辑就变成了下面这样

-----------------------------------------------------------------------------------------------------

1.Spring去数据库连接池拿到一个数据库连接

2.开启事务

3.执行bigTransaction()中的代码

4.提交事务

5.将数据库连接还给数据库连接池中

-----------------------------------------------------------------------------------------------------

这整个过程中,这个连接都会被占用,数据库连接都是有上限的,是非常稀缺的资源

如果所有人都把连接拿去使用很久而没有释放,那么当连接池里面的连接都被拿走了去使用

此时其他请求就没有数据库连接可以使用了,从而导致无法从连接池中获取有效的连接,会导致获取连接超时,而导致请求失败

02.优化1:小事务化

a.说明

将事务最小化,再来看看这段代码

如下,其实getData()方法中是用不到数据库操作的,这个方法里面并没有数据库操作,只有最后的insert才会用到数据库操作

会向db中写入数据,这个时候才会用到数据库的连接,那么我们能不能把这个代码优化下呢,只让最后写数据的时候才用到事务

b.代码

@Transactional

public void bigTransaction() throws InterruptedException {

// 1、getData()方法模拟一个比较耗时的获取数据的操作,这个方法内部会休眠5秒

String data = this.getData();

//2、将上面获取到的数据写入到db中

Lesson007PO po = new Lesson007PO();

po.setId(UUID.randomUUID().toString());

po.setData(data);

this.lesson007Mapper.insert(po);

}

public String getData() throws InterruptedException {

//休眠5秒

TimeUnit.SECONDS.sleep(5);

return UUID.randomUUID().toString();

}

03.优化2:TransactionTemplate

a.说明

Spring为我们提供了一个工具类`TransactionTemplate`,通过这个类

我们可以灵活的控制事务的粒度,这个类就是我们常说的编程式事务

b.优化

下面将上面大事务的代码优化下,为了和上面方法区分,我们将优化后的代码放到一个新的方法中了,如下:

1.将方法上面的 @Transactional 去掉了

2.将最后需要事务操作的insert代码丢到`this.transactionTemplate.executeWithoutResult`,被这个方法包裹起来的代码才会使用spring事务

c.代码

/**

* 使用 TransactionTemplate 编程式事务,可以灵活的控制事务的范围

*

* @throws InterruptedException

*/

public void smallTransaction() throws InterruptedException {

// 1、调用getData()方法,讲获取的数据写到db中,假设 getData方法比较耗时,比如耗时 5秒

String data = this.getData();

//2、将上面获取到的数据写入到db中

Lesson007PO po = new Lesson007PO();

po.setId(UUID.randomUUID().toString());

po.setData(data);

// this.transactionTemplate.executeWithoutResult可以传入一个Consumer,这个Consumer表述需要在事务中执行的业务操作

this.transactionTemplate.executeWithoutResult(action -> {

this.lesson007Mapper.insert(po);

});

}

04.测试

a.为了方便看到测试效果,需要做下面准备

a.TransactionController

提供2个接口分别调用上面2个方法

b.tomcat连接池配置,配置200,这样可以支持200个请求同时过来,测试更真实

server:

tomcat:

threads:

max: 200

min-spare: 200

c.将连接池最大数量设置为20个,获取连接超时时间为3秒

# 这里我们把数据库连接池的最大量配置为20,最小10,获取链接超时时间为3秒,这样方便看到效果

hikari:

maximum-pool-size: 20

minimum-idle: 10

connection-timeout: 3000

b.运行测试用例

a.说明

对这两种事务的接口进行测试,分别对他们进行模拟200个并发请求,然后输出成功数量和失败的数量

b.代码

TransactionControllerTest

@Test

public void test() throws InterruptedException {

System.out.println("对这两种事务的接口进行测试,分别对他们进行模拟100个并发请求,然后输出成功数量和失败的数量");

//对声明式事务的接口进行测试,这个接口内部是大事务

System.out.println("--------------编程式事务接口压测结果------------------");

test("http://localhost:8080/bigTransaction");

//对编程式事务的接口进行测试,这个接口内部是小事务

System.out.println("--------------编程式事务接口压测结果------------------");

test("http://localhost:8080/smallTransaction");

}

c.输出

对这两种事务的接口进行测试,分别对他们进行模拟200个并发请求,然后输出成功数量和失败的数量

--------------声明式事务接口压测结果------------------

23:41:41 - 压测开始......

23:41:47 - 压测结束,总耗时(ms):5711

请求成功数:20

请求失败数:180

--------------编程式事务接口压测结果------------------

23:41:47 - 压测开始......

23:41:52 - 压测结束,总耗时(ms):5253

请求成功数:200

请求失败数:0

-------------------------------------------------------------------------------------------------

明式式事务的接口失败了180次,而编程式事务都成功了,是不是太顶了

d.声明式事务失败的原因

出现了大量下面这种异常,一眼就可以看出来,主要是获取连接超时弹出了异常,导致接口返回失败

-------------------------------------------------------------------------------------------------

2024-03-31 23:17:27.723 ERROR 15124 --- [io-8080-exec-28] c.i.l.controller.TransactionController : 声明式事务 执行异常:Could not open JDBC Connection for transaction; nested exception is java.sql.SQLTransientConnectionException: HikariPool-1 - Connection is not available, request timed out after 3034ms.

2024-03-31 23:17:27.724 ERROR 15124 --- [io-8080-exec-91] c.i.l.controller.TransactionController : 声明式事务 执行异常:Could not open JDBC Connection for transaction; nested exception is java.sql.SQLTransientConnectionException: HikariPool-1 - Connection is not available, request timed out after 3028ms.

2024-03-31 23:17:27.724 ERROR 15124 --- [io-8080-exec-61] c.i.l.controller.TransactionController : 声明式事务 执行异常:Could not open JDBC Connection for transaction; nested exception is java.sql.SQLTransientConnectionException: HikariPool-1 - Connection is not available, request timed out after 3030ms.

2024-03-31 23:17:27.724 ERROR 15124 --- [o-8080-exec-188] c.i.l.controller.TransactionController : 声明式事务 执行异常:Could not open JDBC Connection for transaction; nested exception is java.sql.SQLTransientConnectionException: HikariPool-1 - Connection is not available, request timed out after 3030ms.

1.8 一个通用Excel导出功能

00.汇总

非常通用,能够满足大部分项目中99%的导出功能,代码复用性很强

导出的列可以由前端自定义(比如哪些列需要导出、列的顺序、名称等都是可以由前端自定义)

01.代码实战

a.说明

启动 com.itsoku.lesson007.Lesson008Application

启动好之后,浏览器中打开 http://localhost:8080/userList

b.入参(ExcelExportRequest)

public class ExcelExportRequest {

/**

* excel名称

*/

private String excelName;

/**

* sheet的名称

*/

private String sheetName;

/**

* 导出字段有序列表

*/

private List<ExcelExportField> fieldList;

}

c.出参(ExcelExportResponse)

public class ExcelExportResponse {

//导出的excel文件名称

private String excelName;

// sheet列表数据

private List<ExcelSheet> sheetList;

}

d.Aop拦截请求,将 ExcelExportResponse 处理成excel导出

@Component

@Aspect

public class ExcelExportAspect {

@Around(value = "execution(* com.itsoku..*Controller.*(..))")

public Object around(ProceedingJoinPoint proceedingJoinPoint) throws Throwable {

Object result = proceedingJoinPoint.proceed();

if (result instanceof ExcelExportResponse) {

//下载excel

ExcelExportUtils.writeExcelToResponse((ExcelExportResponse) result);

return null;

} else {

return result;

}

}

}

1.9 自定义一个线程池管理器

00.汇总

系统中所有线程池,负责所有线程池的创建、监控等操作

01.示例

a.代码

com.itsoku.lesson009.common.ThreadPoolManager

b.主要2个方法

newThreadPool:创建一个线程池

threadPoolInfoList:获取线程池管理器中所有的线程池列表,包含每个线程池的各种指标(名称、核心线程数、最大线程数、当前活动线程数、队列容量、队列当前大小等信息),监控系统采集这些信息进行监控告警等处理

02.案例

a.ThreadPoolConfiguration

使用线程池创建2个线程池,一个用户发送邮件,一个用户发送短信

在业务上,通常不同的业务使用不同的线程池,这也叫线程池隔离,互不影响

如果用同一个线程池,比如发邮件和发短信共用一个,那么邮件太多的时候,会导致短信发送延后,影响业务

b.EmailSendService

模拟使用线程池发送邮件

c.ThreadPoolManagerController

暴露了一个接口用于获取线程池管理器中所有线程池列表,可用于监控

d.启动应用

Lesson009Application

e.访问

http://localhost:8080/threadPoolManager/threadPoolInfoList

f.返回

[{

"name": "emailThreadPool",

"corePoolSize": 5,

"maxPoolSize": 10,

"activeCount": 5,

"queueCapacity": 1000,

"queueSize": 84

}, {

"name": "smsThreadPool",

"corePoolSize": 16,

"maxPoolSize": 32,

"activeCount": 0,

"queueCapacity": 1000,

"queueSize": 0

}]

1.10 自定义一个动态线程池

01.定义

无需重启的情况下,可以对线程池进行扩缩容,比如改变线程池的核心线程数量、最大线程数量、队列容量等

02.使用

a.说明

我们会创建一个线程池,然后让其去处理任务,然后对其进行扩缩容

并查看扩缩容前后线程池的各个指标的变化(核心线程数、最大线程数、活动线程数、队列容量、队列中当前元素数量)

b.创建一个线程池

线程池名称:emailThreadPool

核心线程数:10

最大线程数:20

队列容量:1000

-----------------------------------------------------------------------------------------------------

@Bean

public ThreadPoolTaskExecutor emailThreadPool() {

//使用线程池管理器创建线程池

return ThreadPoolManager.newThreadPool("emailThreadPool", 10, 20, 1000);

}

c.启动应用

com.itsoku.lesson009.Lesson009Application

-----------------------------------------------------------------------------------------------------

为了能看到效果,系统中会使用上面刚创建的这个线程池去模拟批量发邮件的一个操作

这样线程池中的一些数据才会发生变化(如:活动线程数、队列中当前元素的数量queueSize 这些指标)

d.看下线程池的信息

系统中暴露了一个接口可以查看到线程池管理器中所有线程池的信息

浏览器中访问:http://localhost:8080/threadPoolManager/threadPoolInfoList

返回如下:

{

"code": "1",

"data": [

{

"name": "emailThreadPool", // 线程池名称

"corePoolSize": 10, // 核心线程数

"maxPoolSize": 20, // 最大线程数

"activeCount": 10, // 活动线程数

"queueCapacity": 1000, // 队列容量

"queueSize": 288 // 队列中当前元素数量

}

],

"msg": null

}

03.演示扩容

a.扩缩容接口

com.itsoku.lesson009.controller.ThreadPoolManagerController#threadPoolChange

-----------------------------------------------------------------------------------------------------

/**

* 线程池扩缩容

*

* @return

*/

@PostMapping("/threadPoolChange")

public Result<Boolean> threadPoolChange(@RequestBody ThreadPoolChange threadPoolChange) {

ThreadPoolManager.changeThreadPool(threadPoolChange);

return ResultUtils.ok(true);

}

b.执行扩容

核心线程数、最大线程数、容量都扩容一倍

-----------------------------------------------------------------------------------------------------

### 测试扩容

POST http://localhost:8080/threadPoolManager/threadPoolChange

Accept: application/json

Content-Type: application/json

{

"name": "emailThreadPool",

"corePoolSize": 50,

"maxPoolSize": 100,

"queueCapacity": 2000

}

c.看下扩容后线程池的信息

浏览器中访问:http://localhost:8080/threadPoolManager/threadPoolInfoList,返回如下:

{

"code": "1",

"data": [

{

"name": "emailThreadPool",

"corePoolSize": 50,

"maxPoolSize": 100,

"activeCount": 50,

"queueCapacity": 2000,

"queueSize": 408

}

],

"msg": null

}

04.演示缩容

a.执行缩容

核心线程数、最大线程数、容量都扩容一倍

-----------------------------------------------------------------------------------------------------

### 测试缩容

POST http://localhost:8080/threadPoolManager/threadPoolChange

Accept: application/json

Content-Type: application/json

{

"name": "emailThreadPool",

"corePoolSize": 5,

"maxPoolSize": 10,

"queueCapacity": 500

}

b.看下扩容后线程池的信息

浏览器中访问:http://localhost:8080/threadPoolManager/threadPoolInfoList,返回如下:

{

"code": "1",

"data": [

{

"name": "emailThreadPool",

"corePoolSize": 5,

"maxPoolSize": 10,

"activeCount": 2,

"queueCapacity": 500,

"queueSize": 0

}

],

"msg": null

}

05.代码示例

a.剖析

a.说明

线程池中会用到Java中的阻塞队列`java.util.concurrent.BlockingQueue`

目前jdk中自带几个阻塞队列都不支持动态扩容,比如`java.util.concurrent.LinkedBlockingQueue`

他里面的capacity是final的,不支持修改,为了是队列容量能够支持调整

我们创建了一个可扩容的阻塞队列`ResizeLinkedBlockingQueue`

代码是从`LinkedBlockingQueue`中拷贝过来的,然后添加了一个可以修改容量capacity的方法

如下,然后创建线程池的时候,我们使用自定义的这个阻塞队列便可以实现线程池的动态扩容

b.代码

/**

* 设置容量

* @param capacity

*/

public void setCapacity(int capacity) {

if (capacity <= 0) throw new IllegalArgumentException();

final ReentrantLock putLock = this.putLock;

putLock.lock();

try {

if (count.get() > capacity) {

throw new IllegalArgumentException();

}

this.capacity = capacity;

} finally {

putLock.unlock();

}

}

b.剖析

a.说明

线程池扩容的方法

b.代码

com.itsoku.lesson009.comm.ThreadPoolManager#changeThreadPool

2 part01

2.1 动态job实战

01.功能

会创建一个job表

可以通过接口,对这些job表进行增删改查

支持动态增加、删除、修改、启动、停止Job等

系统均无需重启,会自动监控job表的变化,实现job的动态执行

02.用到的技术

SpringBoot

MyBatis-Plus

MySql

cron表达式(job执行的一种表达式,如`* * * * * *`表示每秒执行一次 )

03.代码实战

a.系统启动后会自动执行下面的脚本

-- 创建job表

create table if not exists t_job

(

id varchar(50) primary key comment 'id,主键',

name varchar(100) not null comment 'job名称,可以定义一个有意义的名称',

cron varchar(50) not null comment 'job的执行周期,cron表达式',

bean_name varchar(100) not null comment 'job需要执行那个bean,对应spring中bean的名称',

bean_method varchar(100) not null comment 'job执行的bean的方法',

status smallint not null default 0 comment 'job的状态,0:停止,1:执行中'

);

-- 为了方便测试,清理数据

delete from t_job;

-- 创建2个测试用的job,job1每1秒执行1次,job2每2秒执行一次

insert ignore into t_job values ('1', '第1个测试job', '* * * * * *', 'job1', 'execute', 1);

insert ignore into t_job values ('2', '第2个测试job', '*/2 * * * * *', 'job2', 'execute', 1);

b.原理

应用启动后,会自动去job表拉取需要执行的job,进行执行

并每隔5秒对这个 job 表进行一次监控,监控其有没有发生变化

比如这个表中的 job 发生变化(有新增、删除、修改、暂停、启动等操作)都会被自动监控到

然后便实现了 job 的动态执行

c.系统中定义了3个测试用的job

com.itsoku.lesson011.test.Job1

com.itsoku.lesson011.test.Job2

com.itsoku.lesson011.test.Job3

d.启动应用

com.itsoku.lesson011.Lesson011Application

e.可以看到job1和job2在执行了

[main] 18:02:17 :Tomcat started on port(s): 8080 (http) with context path ''

[main] 18:02:17 :Started Lesson011Application in 4.123 seconds (JVM running for 5.989)

[main] 18:02:17 :启动 job 成功:{"id":"1","name":"第1个测试job","cron":"* * * * * *","beanName":"job1","beanMethod":"execute"}

[main] 18:02:17 :启动 job 成功:{"id":"2","name":"第2个测试job","cron":"*/2 * * * * *","beanName":"job2","beanMethod":"execute"}

[taskExecutor-2] 18:02:18 :job1

[taskExecutor-3] 18:02:18 :job2

[taskExecutor-4] 18:02:19 :job1

[taskExecutor-1] 18:02:20 :job2

[taskExecutor-1] 18:02:20 :job1

[taskExecutor-3] 18:02:21 :job1

[taskExecutor-6] 18:02:22 :job1

f.测试各种场景

### 停止job1

POST http://localhost:8080/jobStop?id=1

Accept: application/json

### 启动job1

POST http://localhost:8080/jobStart?id=1

Accept: application/json

### 删除job1

POST http://localhost:8080/jobDelete?id=1

Accept: application/json

### 变更job2,将其执行周期改为每5秒一次

POST http://localhost:8080/jobUpdate

Accept: application/json

Content-Type: application/json

{

"id": "2",

"name": "第2个job",

"cron": "*/5 * * * * *",

"beanName": "job2",

"beanMethod": "execute",

"status": 1

}

### 添加一个job3,每秒执行一次

POST http://localhost:8080/jobCreate

Content-Type: application/json

Accept: application/json

{

"name": "第3个job",

"cron": "* * * * * *",

"beanName": "job3",

"beanMethod": "execute",

"status": 1

}

04.源码解析

a.JobController:job对外暴露的接口

提供对job表的增删改查、job的暂停、启动等接口

b.ThreadPoolTaskScheduler:Spring 框架中用于任务调度的组件

系统中最终job的执行,就是调用`ThreadPoolTaskScheduler`这个类的一些方法去执行的,稍后带大家看下源码。

-----------------------------------------------------------------------------------------------------

@Bean

public ThreadPoolTaskScheduler threadPoolTaskScheduler() {

ThreadPoolTaskScheduler threadPoolTaskScheduler = new ThreadPoolTaskScheduler();

//线程池大小

threadPoolTaskScheduler.setPoolSize(100);

//线程名称前缀

threadPoolTaskScheduler.setThreadNamePrefix("taskExecutor-");

//等待时长

threadPoolTaskScheduler.setAwaitTerminationSeconds(60);

//关闭任务线程时是否等待当前被调度的任务完成

threadPoolTaskScheduler.setWaitForTasksToCompleteOnShutdown(true);

return threadPoolTaskScheduler;

}

c.SpringJobRunManager:动态job执行的的核心代码

这个类是自己写的,内部会监控job表变化,然后动态执行job,目前系统默认是5秒监控一次

05.扩展

a.如何让job支持集群?

目前这个job是单机版本的,可能有朋友会问,线上会是集群的方式执行,那怎么办?这里给2个方案

1.可以在配置文件中加个开关,用开关配置,是否需要这台机器执行,这个方案可能不太友好

2.对每个job加分布式锁,加锁成功才去执行

b.让job支持其他方式调用

案例中job是通过beanName、beanMethod结合反射去调用的,不够灵活

大家可以对这个进行改造,比如支持http接口的方式去调用job或者其他更多方式

大家自由扩展,这样你开发出来的这个job就是比较通用的了

可以直接当成公司的一个job平台去用,会让领导对你刮目相看,同时也提升了技术,双赢

2.2 幂等的4种解决方案

00.汇总

方案1:update时将status=0作为条件判断解决

方案2:乐观锁

方案3:唯一约束 一种通用的方案

方案4:分布式锁

00.概述

a.定义

幂等指多次操作产生的影响只会跟一次执行的结果相同

通俗的说:某个行为重复的执行,最终获取的结果是相同的,不会因为重复执行对系统造成变化

b.例子

比如说咱们有个网站,网站上支持购物,但只能用网站上自己的金币进行付款。

金币从哪里来呢?可通过支付宝充值来,1元对1金币,充值的过程如下

图片说明:充值过程示意图

上图中的第7步,这个地方支付宝会给商家发送通知,商家收到支付宝的通知后会执行下面逻辑

-----------------------------------------------------------------------------------------------------

step1.判.断订单是否处理过

step2.若订单已处理,则直接返回SUCCESS,否则继续向下走

step3.将订单状态置为成功

step4.给用户在平台的账户加金币

step5.返回SUCCESS

-----------------------------------------------------------------------------------------------------

由于网络存在不稳定的因素,这个通知可能会发送多次

极端情况下,同一笔订单的多次通知可能同时到达商户端,若商家这边不做幂等操作,那么同一笔订单就可能被处理多次

比如2次通知同时走到step2,都会看到订单未处理,则会继续向下走,那么账户就会被加2次钱

这将出现严重的事故,搞不好公司就被干倒闭了

c.如何解决这个问题?

本文中,我会给大家提供4种方案,每种方案都会有代码落地,以及会对每种方案进行并发压测,验证其可靠性

d.先添加2张表(账户表、充值订单表)

-- 创建账户表

create table if not exists t_account

(

id varchar(50) primary key comment '账户id',

name varchar(50) not null comment '账户名称',

balance decimal(12, 2) not null default '0.00' comment '账户余额'

) comment '账户表';

-- 充值记录表

create table if not exists t_recharge

(

id varchar(50) primary key comment 'id,主键',

account_id varchar(50) not null comment '账户id,来源于表t_account.id',

price decimal(12, 2) not null comment '充值金额',

status smallint not null default 0 comment '充值记录状态,0:处理中,1:充值成功',

version bigint not null default 0 comment '系统版本号,默认为0,每次更新+1,用于乐观锁'

) comment '充值记录表';

-- 准备测试数据,

-- 账号数据来一条,

insert ignore into t_account values ('1', '路人', 0);

-- 充值记录来一条,状态为0,稍后我们模拟回调,会将状态置为充值成功

insert ignore into t_recharge values ('1', '1', 100.00, 0, 0);

-----------------------------------------------------------------------------------------------------

下面我们将实现,业务方这边给支付宝提供的回调方法,在这个回调方法中会处理刚才上面sql中插入的那个订单

会将订单状态置为成功,成功也就是1,然后给用户的账户余额中添加100金币

这个回调方法,下面会提供4种实现,都可以确保这个回调方法的幂等性,余额只会加100

01.方案1:update时将status=0作为条件判断解决

a.原理

逻辑如下,重点在于更新订单状态的时候要加上status = 0这个条件

如果有并发执行到这条sql的时候,数据库会对update的这条记录加锁,确保他们排队执行,只有一个会执行成功

-----------------------------------------------------------------------------------------------------

String rechargeId = "充值订单id";

// 根据rechargeId去找充值记录,如果已处理过,则直接返回成功

RechargePO rechargePo = select * from t_recharge where id = #{rechargeId};

// 充值记录已处理过,直接返回成功

if(rechargePo.status==1){

return "SUCCESS";

}

-----------------------------------------------------------------------------------------------------

// 开启Spring事务

// 下面这个sql是重点,重点在where后面要加 status = 0 这个条件;count表示影响行数

int count = (update t_recharge set status = 1 where id = #{rechargeId} and status = 0);

// count = 1,表示上面sql执行成功

if(count!=1){

// 走到这里,说明有并发,直接抛出异常

throw new RuntimeException("系统繁忙,请重试")

}else{

//给账户加钱

update t_account set balance = balance + #{rechargePo.price} where id = #{rechargePo.accountId}

}

// 提交Spring事务

b.源码

com.itsoku.lesson012.controller.RechargeController#rechargeCallBack1

c.运行看结果

RechargeControllerTest#rechargeCallBack1

-----------------------------------------------------------------------------------------------------

并发100次请求对这个方案进行压测,在压测前后,我们会打印出订单的状态、账户的余额,大家注意看着几个数据。

预期的结果,订单状态应该是1,账户余额应该是100

-----------------------------------------------------------------------------------------------------

-----------------------------方案1 幂等测试----------------------------------------

测试前,充值订单&账户信息:充值订单号:1,状态:0,账户余额:0.00

接口:http://localhost:8080/rechargeCallBack1?rechargeId=1

[main] 22:08:26 :压测开始......共发送请求数量:100,并发量:100

[main] 22:08:27 :压测结束,总耗时(ms):170

测试后,充值订单&账户信息:充值订单号:1,状态:1,账户余额:100.00

02.方案2:乐观锁

a.原理

String rechargeId = "充值订单id";

// 根据rechargeId去找充值记录,如果已处理过,则直接返回成功

RechargePO rechargePo = select * from t_recharge where id = #{rechargeId};

// 充值记录已处理过,直接返回成功

if(rechargePo.status==1){

return "SUCCESS";

}

// 开启Spring事务

// 期望的版本号

Long exceptVersion = rechargePo.version;

// 下面这个sql是重点,重点在set后面要有version = version + 1,where后面要加 status = 0 这个条件;count表示影响行数

int count = (update t_recharge set status = 1,version = version + 1 where id = #{rechargeId} and version = #{exceptVersion});

// count = 1,表示上面sql执行成功

if(count!=1){

// 走到这里,说明有并发,直接抛出异常

throw new RuntimeException("系统繁忙,请重试")

}else{

//给账户加钱

update t_account set balance = balance + #{rechargePo.price} where id = #{rechargePo.accountId}

}

// 提交spring事务

-----------------------------------------------------------------------------------------------------

重点在于update t_recharge set status = 1,version = version + 1 where id = #{rechargeId} and version = #{exceptVersion}这条sql

set 后面必须要有 version = version + 1

where后面必须要有 version = #{exceptVersion}

这样乐观锁才能起作用

b.源码

com.itsoku.lesson012.controller.RechargeController#rechargeCallBack2

c.运行看结果

RechargeControllerTest#rechargeCallBack2

并发100次请求对这个方案进行压测,在压测前后,我们会打印出订单的状态、账户的余额,大家注意看着几个数据。

预期的结果,订单状态应该是1,账户余额应该是100

-----------------------------------------------------------------------------------------------------

-----------------------------方案2 幂等测试----------------------------------------

测试前,充值订单&账户信息:充值订单号:1,状态:0,账户余额:0.00

接口:http://localhost:8080/rechargeCallBack2?rechargeId=1

[main] 22:08:44 :压测开始......共发送请求数量:100,并发量:100

[main] 22:08:44 :压测结束,总耗时(ms):156

测试后,充值订单&账户信息:充值订单号:1,状态:1,账户余额:100.00

03.方案3:唯一约束

a.需要添加一张唯一约束辅助表

如下,这个表重点关注第二个字段idempotent_key,这个字段添加了唯一约束

说明同时向这个表中插入同样值的idempotent_key,则只有一条记录会执行成功,其他的请求会报异常

而失败,让事务回滚,这个知识点了解后,方案就容易看懂了

-----------------------------------------------------------------------------------------------------

-- 幂等辅助表

create table if not exists t_idempotent

(

id varchar(50) primary key comment 'id,主键',

idempotent_key varchar(200) not null comment '需要确保幂等的key',

unique key uq_idempotent_key (idempotent_key)

) comment '幂等辅助表';

b.原理

String idempotentKey = "幂等key";

// 幂等表是否存在记录,如果存在说明处理过,直接返回成功

IdempotentPO idempotentPO = select * from t_idempotent where idempotent_key = #{idempotentKey};

if(idempotentPO!=null){

return "SUCCESS";

}

// 开启Spring事务(这里千万不要漏掉,一定要有事务)

// 这里放入需要幂等的业务代码,最好是db操作的代码。。。。。

String idempotentId = "";

// 这里是关键一步,向 t_idempotent 插入记录,如果有并发过来,只会有一个成功,其他的会报异常导致事务回滚

insert into t_idempotent (id, idempotent_key) values (#{idempotentId}, #{idempotentKey});

// 提交spring事务

c.用这种方案来处理支付回调通知,伪代码如下

String rechargeId = "充值订单id";

// 根据rechargeId去找充值记录,如果已处理过,则直接返回成功

RechargePO rechargePo = select * from t_recharge where id = #{rechargeId};

// 充值记录已处理过,直接返回成功

if(rechargePo.status==1){

return "SUCCESS";

}

// 生成idempotentKey,这里可以使用,业务id:业务类型,那么我们这里可以使用rechargeId+":"+"RECHARGE_CALLBACK"

String idempotentKey = rechargeId+":"+"RECHARGE_CALLBACK";

// 幂等表是否存在记录,如果存在说明处理过,直接返回成功

IdempotentPO idempotentPO = select * from t_idempotent where idempotent_key = #{idempotentKey};

if(idempotentPO!=null){

return "SUCCESS";

}

// 开启Spring事务(这里千万不要漏掉,一定要有事务)

// count表示影响行数,这个sql比较特别,看起来并发会出现问题,实际上配合唯一约束辅助表,就不会有问题了

int count = update t_recharge set status = 1 where id = #{rechargeId};

// count != 1,表示未成功

if(count!=1){

// 走到这里,直接抛出异常,让事务回滚

throw new RuntimeException("系统繁忙,请重试")

}else{

//给账户加钱

update t_account set balance = balance + #{rechargePo.price} where id = #{rechargePo.accountId}

}

String idempotentId = "";

// 这里是关键一步,向 t_recharge 插入记录,如果有并发过来,只会有一个成功,其他的会报异常导致事务回滚,上面的

insert into t_recharge (id, idempotent_key) values (#{idempotentId}, #{idempotentKey});

// 提交spring事务

d.源码

com.itsoku.lesson012.controller.RechargeController#rechargeCallBack3

e.运行看结果

RechargeControllerTest#rechargeCallBack3

并发100次请求对这个方案进行压测,在压测前后,我们会打印出订单的状态、账户的余额,大家注意看着几个数据。

预期的结果,订单状态应该是1,账户余额应该是100

-----------------------------------------------------------------------------------------------------

-----------------------------方案3 幂等测试----------------------------------------

测试前,充值订单&账户信息:充值订单号:1,状态:0,账户余额:0.00

接口:http://localhost:8080/rechargeCallBack3?rechargeId=1

[main] 22:08:59 :压测开始......共发送请求数量:100,并发量:100

[main] 22:08:59 :压测结束,总耗时(ms):127

测试后,充值订单&账户信息:充值订单号:1,状态:1,账户余额:100.00

04.方案4:分布式锁

上面三种方式都是依靠数据库的功能解决幂等性的问题,所以比较适合对数据库操作的业务

若业务没有数据库操作,需要实现幂等,可用分布式锁解决

2.3 并行查询,可能有坑

01.并行查询可能存在的问题?

a.说明

如果上面执行并行查询用到的线程池配置不当,可能导致比较严重的性能问题

b.说明

比如将核心线程数设置为了1,而队列大小没有限制,那么所有的请求都变成串行了,会导致请求响应非常慢,出现大事故

或者核心线程数设置的比较小,比如10,而队列大小没有设置上限,那么这个线程池同时只可支持10个任务并行

其他的请求进入这个接口后都变成串行执行了,进入队列排队,从而导致接口响应特别慢

c.怎么解决这个问题?

a.说明

解决这个问题本质是不要让任务排队或者排队时间不要太长

这个时候我们就要先说一下线程池的原理了,了解原理之后,就知道如何破解这个问题

b.了解了这个过程我们就有优化办法了,如下

1.可以将核心线程数、最大线程数调大,但是也不能随便调,比如调的很大,反而会降低系统性能,建议调的过程中根据业务的指标进行压测得到一个合理的值

2.将队列大小设置的比较小,这样排队的时间大概率会比较短,或者排队失败,直接后面的流程

LinkedBlockingQueue、ArrayBlockingQueue` 容量是不允许为0的,如果需要用到容量为0的队列,则需要使用同步阻塞队列`SynchronousQueue`

3.将队列大小设置为0,这样任务就不会进入队列,而直接创建新的线程去执行,或者走拒绝策略

4.拒绝策略可以使用`CallerRunsPolicy`,这个策略是直接在当前线程执行,即如果线程池执行不了,则自己去执行,这样至少不会一直等着

5.线程池隔离,不同的业务最好使用不同的线程池,互不影响,强烈建议核心业务一定要使用单独的线程池。

c.优化后的线程池配置

@Bean

public ThreadPoolTaskExecutor goodsThreadPool() {

ThreadPoolTaskExecutor threadPoolTaskExecutor = new ThreadPoolTaskExecutor();

threadPoolTaskExecutor.setThreadNamePrefix("ThreadPool-Goods-");

// 核心线程数为cpu核数 * 4,最大线程数据为cpu核数 * 8

threadPoolTaskExecutor.setCorePoolSize(Runtime.getRuntime().availableProcessors() * 4);

threadPoolTaskExecutor.setMaxPoolSize(Runtime.getRuntime().availableProcessors() * 8);

// 队列容量为0,则任务就不会进入队列

threadPoolTaskExecutor.setQueueCapacity(0);

// 拒绝策略使用CallerRunsPolicy,让当前线程去兜底去执行任务

threadPoolTaskExecutor.setRejectedExecutionHandler(new ThreadPoolExecutor.CallerRunsPolicy());

return threadPoolTaskExecutor;

}

2.4 接口通用返回值设计与实现

01.接口返回值通用格式

a.通常会有4个字段

public class Result<T> {

/**

* 请求是否处理成功?

*/

private boolean success;

/**

* 数据,泛型类型,后端需要返回给前端的业务数据可以放到这个里面

*/

public T data;

/**

* 提示消息,如success为false的时给用户的提示信息

*/

private String msg;

/**

* 错误编码,某些情况下,后端可以给前端提供详细的错误编码,前端可以根据不同的编码做一些不同的操作

*/

private String code;

}

b.接口示例代码如下,返回值为Result类型

@RestController

public class TestController {

@GetMapping("/hello")

public Result<String> hello() {

return ResultUtils.success("欢迎大家学习《高并发 & 微服务 & 性能调优实战案例 100 讲》");

}

}

c.前端调用此接口,看到的结果如下

{

"success": true,

"data": "欢迎大家学习《高并发 & 微服务 & 性能调优实战案例 100 讲》",

"msg": null,

"code": null

}

02.异常情况处理

a.说明

后端的接口中,通常,都是有一些校验功能的

比如登录接口中,需要验证用户名或密码是否正确,如果不正确需要提示前端:用户名或密码不正确,给前端返回下面的数据

b.代码

{

"success": false,

"data": null,

"msg": "1001",

"code": "用户名或密码错误"

}

c.说明

代码中我们可以怎么写呢?后端校验不通过的时候,可以抛出一个业务异常

然后在全局异常处理中去处理这个异常,返回通用格式的结果

03.具体怎么做呢?

a.自定义一个业务异常类

public class BusinessException extends RuntimeException {

private String code;

/**

* @param code 错误编码

* @param message 错误提示

*/

public BusinessException(String code, String message) {

super(message);

this.code = code;

}

public BusinessException(String code, String message, Throwable cause) {

super(message, cause);

this.code = code;

}

public String getCode() {

return code;

}

public void setCode(String code) {

this.code = code;

}

}

b.接口中抛出业务异常

登录接口可以用下面这种写法了,用户名不对的时候,抛出一个业务异常BusinessException

-----------------------------------------------------------------------------------------------------

@GetMapping("/login")

public Result<String> login(String name) {

if (!"路人".equals(name)) {

throw new BusinessException("1001", "用户名错误");

} else {

return ResultUtils.success("登录成功");

}

}

04.全局异常中对BusinessException异常进行统一处理

a.说明

BusinessException这个异常可以使用springboot中的全局异常处理器去处理

b.定义一个全局异常处理器

a.说明

类上使用 @RestControllerAdvice 注解标注

注意看handleBusinessException方法,这个方法上有个 @ExceptionHandler(BusinessException.class) 注解

这个注解的值是 BusinessException,表示接口中抛出这个异常的时候,会进入到 handleBusinessException 方法中去处理

这个方法最后返回的也是通用的结果Result类型

b.代码

@RestControllerAdvice

public class GlobalExceptionHandler {

private Logger logger = LoggerFactory.getLogger(GlobalExceptionHandler.class);

/**

* 处理业务异常

*

* @param e

* @param request

* @return

*/

@ExceptionHandler(BusinessException.class)

public Result handleBusinessException(BusinessException e, HttpServletRequest request) {

logger.info("请求:{},发生异常:{}", request.getRequestURL(), e.getMessage(), e);

return ResultUtils.error(e.getCode(), e.getMessage());

}

}

c.此时我们验证下上面这个登录接口

a.用户名正确

http://localhost:8080/login?name=路人

{

"success": true,

"data": "登录成功",

"msg": null,

"code": null

}

c.用户名错误

http://localhost:8080/login?name=张三

{

"success": false,

"data": null,

"msg": "用户名或密码错误",

"code": "1001"

}

05.案例:SpringBoot自带的参数校验功能异常处理

a.用户注册接口

com.itsoku.lesson013.controller.TestController#register

@PostMapping("/userRegister")

public Result<Void> userRegister(@Validated @RequestBody UserRegisterRequest req) {

return ResultUtils.success();

}

b.当参数校验不通过的时候

会自动抛出一个org.springframework.validation.BindException异常

c.对应的全局异常处理方法

@ExceptionHandler(BindException.class)

public Result handleBindException(BindException e, HttpServletRequest request) {

logger.info("请求:{},发生异常:{}", request.getRequestURL(), e.getMessage(), e);

String message = e.getAllErrors().get(0).getDefaultMessage();

return ResultUtils.error(message);

}

06.全局其他异常处理

a.说明

当上面的异常处理方法都无法匹配接口中的异常的时候,将走下面这个方法去处理异常,这个是用来对异常处理进行兜底的

b.代码

/**

* 处理其他异常

*

* @param e

* @param request

* @return

*/

@ExceptionHandler(Exception.class)

public Result handleException(Exception e, HttpServletRequest request) {

logger.info("请求:{},发生异常:{}", request.getRequestURL(), e.getMessage(), e);

//会返回code为500的一个异常

return ResultUtils.error(ErrorCode.SERVER_ERROR,"系统异常,请稍后重试");

}

07.提供的几个工具类

com.itsoku.lesson013.common.ResultUtils:提供了创建Result对象的一些静态方法

com.itsoku.lesson013.common.BusinessExceptionUtils:提供了创建BusinessException的一些静态方法

com.itsoku.lesson013.common.ErrorCode:将系统中所有的错误编码可以放到这个类中集中化管理

2.5 接口太多,解决DTO、VO泛滥

01.问题

有些项目接口很多,而接口入参一般我们使用XxxDTO这种类型参数,返回值通常使用XxxVO这种类型

很多开发按照自己项目搞事情,时间久了,导致系统中充斥着大量的dto、vo命名的类,各种命名千奇百怪

问题来了,然后我们再添加新的接口的时候,入参和返回值不知道如何命名了,大家有没有这种经历?

02.elasticsearch示例

a.说明

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-elasticsearch</artifactId>

</dependency>

b.springboot端提供的一个用于调用elasticsearch服务端接口的工具类

co.elastic.clients.elasticsearch.ElasticsearchClient

IndexResponse index(IndexRequest request)

ReindexResponse reindex(ReindexRequest request)

DeleteResponse delete(DeleteRequest request)

DeleteByQueryResponse deleteByQuery(DeleteByQueryRequest request)

DeleteScriptResponse deleteScript(DeleteScriptRequest request)

c.上面方法的特点

入参的类型是:方法名称+Request

返回值的类型是:方法名称+Response

2.6 复杂业务,如何传参

00.汇总

优化前

优化后

使用上下文对象来解决

01.优化前

a.代码

package com.itsoku.lesson016;

public class XxxService {

/**

* 这个方法是对外暴露的接口

*

* @param request

*/

public void execute(M1Request request) {

//m1方法中会产生Obj1,Obj2

this.m1(request);

//下面m2方法中要用到m1方法中产生的Obj1、Obj2,而m2本身又会返回obje3

Obj1 obj1 = null;

Obj2 obj2 = null;

Obj3 obj3 = this.m2(obj1, obj2);

//m3方法中又会用到4个参数:request、obj1、obj2、obj3

this.m3(request, obj1, obj2, obj3);

}

private void m1(M1Request request) {

System.out.println(request);

//这里会产生2个对象

Obj1 obj1 = new Obj1();

Obj2 obj2 = new Obj2();

}

private Obj3 m2(Obj1 obj1, Obj2 obj2) {

System.out.println(obj1);

System.out.println(obj2);

//这里需要用到 obj1,obj2

Obj3 obj3 = new Obj3();

return obj3;

}

private void m3(M1Request request, Obj1 obj1, Obj2 obj2, Obj3 obj3) {

System.out.println(request);

System.out.println(obj1);

System.out.println(obj2);

System.out.println(obj3);

}

}

b.上面代码如何拿到m1方法中创建的2个对象呢?

// 我们可以创建一个类,用来作为m1方法的返回值,用来存放m1方法中的ojb1、obj2

public class M1Result {

private Obj1 obj1;

private Obj2 obj2;

public Obj1 getObj1() {

return obj1;

}

public void setObj1(Obj1 obj1) {

this.obj1 = obj1;

}

public Obj2 getObj2() {

return obj2;

}

public void setObj2(Obj2 obj2) {

this.obj2 = obj2;

}

}

02.优化后

a.代码

package com.itsoku.lesson016;

public class XxxService1 {

/**

* 这个方法是对外暴露的接口

*

* @param request

*/

public void execute(M1Request request) {

//m1方法中会产生Obj1,Obj2

M1Result m1Result = this.m1(request);

//下面m2方法中要用到m1方法中产生的Obj1、Obj2

Obj1 obj1 = m1Result.getObj1();

Obj2 obj2 = m1Result.getObj2();

Obj3 obj3 = this.m2(obj1, obj2);

//m3方法中又会用到4个参数:request、obj1、obj2、obj3

this.m3(request, obj1, obj2, obj3);

}

private M1Result m1(M1Request request) {

System.out.println(request);

Obj1 obj1 = new Obj1();

Obj2 obj2 = new Obj2();

M1Result result = new M1Result();

result.setObj1(obj1);

result.setObj2(obj2);

return result;

}

private Obj3 m2(Obj1 obj1, Obj2 obj2) {

System.out.println(obj1);

System.out.println(obj2);

//这里需要用到 obj1,obj2

Obj3 obj3 = new Obj3();

return obj3;

}

private void m3(M1Request request, Obj1 obj1, Obj2 obj2, Obj3 obj3) {

System.out.println(request);

System.out.println(obj1);

System.out.println(obj2);

System.out.println(obj3);

}

}

b.假如execute方法中还有后续代码,如下

public void execute(M1Request request) {

//m1方法中会产生Obj1,Obj2

M1Result m1Result = this.m1(request);

//下面m2方法中要用到m1方法中产生的Obj1、Obj2

Obj1 obj1 = m1Result.getObj1();

Obj2 obj2 = m1Result.getObj2();

Obj3 obj3 = this.m2(obj1, obj2);

//m3方法中又会用到4个参数:request、obj1、obj2、obj3

this.m3(request, obj1, obj2, obj3);

// 下面还有其他业务方法,内部也会产生一些对象,后续一些方法可能需要用到这些对象,有没有更好的解决方案呢?

}

03.使用上下文对象来解决

a.说明

可以创建一个上下文对象,为这个业务服务,上下文对象中存放了这个业务中所有需要用到的对象

这些对象都可以放到里面,后面的方法如果需要用到相关对象的时候,直接从上下文对象中存取就可以了

b.代码

// 定义一个上下文对象,通常以Context作为后缀,定义如下,目前这个案例中需要用到4个对象,都在这个类中包含了

package com.itsoku.lesson016;

public class XxxContext {

private M1Request request;

private Obj1 obj1;

private Obj2 obj2;

private Obj3 obj3;

// getter、setter方法

}

c.代码

// 引入这个上下文对象后,优化后的代码,如下,重点在于方法的参数类型都改成了 XxxContext

// 这样在方法中就可以从这个上线文中获取到需要使用的对象了,产生的新对象也可以丢到里面,是不是方便了很多?

package com.itsoku.lesson016;

public class XxxService3 {

/**

* 这个方法是对外暴露的接口

*

* @param request

*/

public void execute(M1Request request) {

XxxContext context = new XxxContext();

//m1方法中会产生Obj1,Obj2

this.m1(context);

//下面m2方法中要用到m1方法中产生的Obj1、Obj2

this.m2(context);

//m3方法中又会用到4个参数:request、obj1、obj2、obj3

this.m3(context);

// 下面还有其他业务方法,内部也会产生一些对象,后续一些方法可能需要用到这些对象,有没有更好的解决方案呢?

this.otherMethod(context);

}

private void m1(XxxContext context) {

System.out.println(context.getRequest());

Obj1 obj1 = new Obj1();

Obj2 obj2 = new Obj2();

context.setObj1(obj1);

context.setObj2(obj2);

}

private void m2(XxxContext context) {

//这里需要用到 obj1,obj2

System.out.println(context.getObj1());

System.out.println(context.getObj2());

Obj3 obj3 = new Obj3();

context.setObj3(obj3);

}

private void m3(XxxContext context) {

System.out.println(context.getRequest());

System.out.println(context.getObj1());

System.out.println(context.getObj2());

System.out.println(context.getObj3());

}

private void otherMethod(XxxContext context) {

}

}

2.7 接口报错,如何快速定位日志?

00.思考拓展?

1.如果接口中有子线程,那么子线程中能获取到这个traceId么?

2.如果接口涉及到内部的多个服务,那么多个服务中如何共享这个traceId呢?

01.要解决的问题?

接口报错,如何快速定位问题?这个需要日志的辅助,一般错误日志中有详细的堆栈信息,具体是哪行代码报错,都可以看到

要想快速定位问题,前提是要能够快速定位日志

海量日志,如何定位呢?日志量一般都是很大的,如何能够从大量日志中找到自己需要的日志呢?

02.解决方案

1.服务端入口处可以生成一个唯一的id,记做:traceId

2.日志中均需要输出traceId的值

3.接口返回值中,添加一个通用的字段:traceId,将上面的traceId作为这个字段的值

4.这样前端发现接口有问题的时候,直接将这个traceId提供给我们,我们便可以在日志中快速查询出对应的日志

03.代码实战

a.添加一个TraceFilter

// 拦截所有请求,入口生成一个唯一的traceId,放到ThreadLocal中

@Order(Ordered.HIGHEST_PRECEDENCE)

@WebFilter(urlPatterns = "/**", filterName = "TraceFilter")

public class TraceFilter extends OncePerRequestFilter {

public static Logger logger = LoggerFactory.getLogger(TraceFilter.class);

@Override

protected void doFilterInternal(HttpServletRequest request, HttpServletResponse response, FilterChain filterChain) throws ServletException, IOException {

String traceID = IdUtil.fastSimpleUUID();

TraceUtils.setTraceId(traceID);

long st = System.currentTimeMillis();

try {

filterChain.doFilter(request, response);

} finally {

long et = System.currentTimeMillis();

logger.info("请求地址:{},耗时(ms):{}", request.getRequestURL().toString(), (et - st));

TraceUtils.removeTraceId();

}

}

}

b.日志中输出traceId

需要在MDC中设置一下traceId:MDC.put("traceId", traceId);

MDC是logback为我们提供的一个扩展的入口,可以向里面放入一些键值对,然后在logback中的日志中就可以通过这个traceId获取到对应的值

如下,logback.xml中使用`%X{traceId}`可以获取到MDC中设置的traceId

c.返回值中添加通用字段traceId

public class Result<T> {

private boolean success;

public T data;

private String msg;

private String code;

// 链路追踪id

private String traceId;

d.通过aop将traceId写入响应结果的Result中

// 下面我们使用aop创建了一个环绕通知,会拦截controller的所有方法,以及全局异常处理器的方法

// 对Result类型的返回值进行统一处理,将traceId设置到Result中traceId字段中

@Aspect

@Order(Ordered.LOWEST_PRECEDENCE)

public class ResultTraceIdAspect {

@Pointcut("execution(* com.itsoku..*Controller.*(..)) ||execution(* com.itsoku.lesson017.web.GlobalExceptionHandler.*(..))")

public void pointCut() {

}

@Around("pointCut()")

public Object around(ProceedingJoinPoint pjp) throws Throwable {

Object object = pjp.proceed();

if (object instanceof Result) {

((Result<?>) object).setTraceId(TraceUtils.getTraceId());

}

return object;

}

}

e.测试效果

访问接口`http://localhost:8080/`,输出

{

"success": true,

"data": "欢迎和路人一起学习《高并发 & 微服务 & 性能调优实战案例100讲》",

"msg": null,

"code": null,

"traceId": "92558e52c28845b39c6bf4b76235ffdd"

}

通过这个traceId可以去控制台找到对应的日志

f.测试异常情况,快速定位日志

a.下面提供了一个测试接口,这个接口会抛出异常,代码中有:10/0,除数是零,会报异常

@GetMapping("/exception")

public Result<String> exception() throws InterruptedException {

logger.info("开始执行业务");

//这里模拟了一个错误,10/0,会报错

System.out.println(10/0);

logger.info("业务执行结束");

return ResultUtils.success("欢迎和路人一起学习《高并发 & 微服务 & 性能调优实战案例100讲》");

}

b.访问下这个接口`http://localhost:8080/exception`,输出

{

"success": false,

"data": null,

"msg": "系统异常,请稍后重试",

"code": "500",

"traceId": "b9141d327de645f9ba2f736009a35dc7"

}

c.通过这个traceId去查找下日志

略

2.8 线程局部变量:TL、ITL、TTL

00.汇总

1.ThreadLocal:在当前线程中共享数据的,JUC 中提供的

2.InheritableThreadLocal:也是JUC中的一个工具类,解决 ThreadLocal 难以解决的问题

3.TransmittableThreadLocal:阿里开源的一个工具类,解决上面2个ThreadLocal 难以搞定的问题

01.案例1:ThreadLocal 可以在当前线程中共享数据

a.用法

在当前线程中,调用 ThreadLocal.set()可以向当前线程中存入数据

然后在当前线程的其他位置可以调用 ThreadLocal.get() 获取当刚才放入的数据

要点:ThreadLocal.set() 和 ThreadLocal.get() 需要再同一个线程中执行

b.原理

当前线程有个Map,key就是ThreadLocal对象,value就是通过ThreadLocal.set方法放入的值,如下

当前线程.map.put(threadLocal对象,threadLocal.set的值);

然后通过这个map和threadLocal就可以取到值了,如下

当前线程.map.get(threadLocal对象);

c.代码

//①:这里创建了一个 ThreadLocal

ThreadLocal<String> userNameTL = new ThreadLocal<>();

/**

* ThreadLocal 可以在当前线程中存储数据

* @throws InterruptedException

*/

@Test

public void threadLocalTest1() throws InterruptedException {

//这里是主线程,将用户名放入 userNameTL 中

userNameTL.set("张三");

//在m1中,取上面放入用户名名,看看是不是张三?

m1();

//这里创建了线程 thread1,里面放入了李四,然后在m1中取出用户名,看看是不是李四?

new Thread(() -> {

userNameTL.set("李四");

m1();

}, "thread1").start();

//这里创建了线程 thread2,里面放入了王五,然后在m1中取出用户名,看看是不是王五

new Thread(() -> {

userNameTL.set("王五");

m1();

}, "thread2").start();

TimeUnit.SECONDS.sleep(1);

}

public void m1() {

logger.info("userName:{}", userNameTL.get());

}

d.运行输出

17:13:40 [main] m1 - userName:张三

17:13:40 [thread1] m1 - userName:李四

17:13:41 [thread2] m1 - userName:王五

-----------------------------------------------------------------------------------------------------

1.主线程(线程名称:main)中放入了张三,取出来也是张三

2.线程 thread1 中放入了李四,取出来也是李四

3.线程 thread2 中放入了王五,取出来也是王五

e.结论

通过ThreadLocal可以在当前线程中共享数据,通过其set方法在当前线程中设置值

然后在当前线程的其他任何位置,都可以通过ThreadLocal的get方法获取到这个值

02.案例2:子线程是否可以获取ThreadLocal中的值呢?

a.代码

@Test

public void threadLocalTest2() throws InterruptedException {

//这里是主线程,ThreadLocal中设置了值:张三

userNameTL.set("张三");

logger.info("userName:{}", userNameTL.get());

//创建了一个子线程thread1,在子线程中去ThreadLocal中拿值,能否拿到刚才放进去的“张三”呢?

new Thread(() -> {

logger.info("userName:{}", userNameTL.get());

}, "thread1").start();

TimeUnit.SECONDS.sleep(1);

}

b.执行输出

15:08:47 [main] threadLocalTest2 - userName:张三

15:08:47 [thread1] lambda$threadLocalTest2$2 - userName:null

-----------------------------------------------------------------------------------------------------

子线程中没有拿到父线程中放进去的"张三",说明ThreadLocal只能在当前线程中共享数据

c.结论

子线程无法获取父线程ThreadLocal中的set数据

通过上面2个案例,可知ThreadLocal生效的条件是:其set和get方法必须在同一个线程才能共享数据

那么有没有方法解决这个问题呢?(父线程中set数据,子线程中可以get到这个数据的)

JUC中的工具类 InheritableThreadLocal 可以解决这个问题

03.案例3:InheritableThreadLocal(子线程可以获取父线程中存放的数据)

a.代码

// 这里定义了一个 InheritableThreadLocal 对象

private InheritableThreadLocal<String> userNameItl = new InheritableThreadLocal<>();

@Test

public void inheritableThreadLocal1() throws InterruptedException {

//这里是主线程,使用 InheritableThreadLocal.set 放入值:张三

userNameItl.set("张三");

logger.info("userName:{}", userNameItl.get());

//创建了一个子线程thread1,在子线程中去ThreadLocal中拿值,能否拿到刚才放进去的“张三”呢?

new Thread(() -> {

logger.info("userName:{}", userNameItl.get());

}, "thread1").start();

TimeUnit.SECONDS.sleep(1);

}

b.执行输出

19:35:48 [main] inheritableThreadLocal1 - userName:张三

19:35:48 [thread1] lambda$inheritableThreadLocal1$3 - userName:张三

c.结论

使用 InheritableThreadLocal ,子线程可以访问到父线程中通过InheritableThreadLocal.set进去的值

04.案例4:InheritableThreadLocal:遇到线程池,会怎么样呢?

a.代码

private InheritableThreadLocal<String> userNameItl = new InheritableThreadLocal<>();

@Test

public void inheritableThreadLocal2() throws InterruptedException {

//为了看到效果,这里创建大小为1的线程池,注意这里为1才能方便看到效果

ExecutorService executorService = Executors.newFixedThreadPool(1);

//主线程中,放入了张三

userNameItl.set("张三");

logger.info("userName:{}", userNameItl.get());

//在线程池中通过 InheritableThreadLocal 拿值,看看能否拿到 刚才放入的张三?

executorService.execute(() -> {

logger.info("第1次获取 userName:{}", userNameItl.get());

});

//这里稍微休眠一下,等待上面的任务结束

TimeUnit.SECONDS.sleep(1);

//这里又在主线程中放入了李四

userNameItl.set("李四");

logger.info("userName:{}", userNameItl.get());

//这里又在线程池中通过 InheritableThreadLocal.get 方法拿值,看看能否拿到 刚才放入的李四?

executorService.execute(() -> {

//在线程池中通过 inheritableThreadLocal 拿值,看看能否拿到?

logger.info("第2次获取 userName:{}", userNameItl.get());

});

TimeUnit.SECONDS.sleep(1);

}

b.执行输出

20:52:03 [main] inheritableThreadLocal2 - userName:张三

20:52:03 [pool-1-thread-1] lambda$inheritableThreadLocal2$4 - 第1次获取 userName:张三

20:52:04 [main] inheritableThreadLocal2 - userName:李四

20:52:04 [pool-1-thread-1] lambda$inheritableThreadLocal2$5 - 第2次获取 userName:张三

c.分析下结果

从结果中看,线程池执行了2次任务,2次拿到的都是张三,和主线程第一次放入的值是一样的

而第二次主线程中放入的是李四啊,但是第二次线程池中拿到的却是张三,这是什么原因?

-----------------------------------------------------------------------------------------------------

上面线程池的大小是1,也就是说这个线程池中只有一个线程,所以让线程池执行的2次任务用到的都是一个线程

从上面的日志中可以看到线程名称都是`pool-1-thread-1`,说明这两次任务,都是线程池中同一个线程执行的

-----------------------------------------------------------------------------------------------------

线程池中的线程是重复利用的,线程池中的`pool-1-thread-1`这个线程是什么时候创建的呢?谁创建的?他的父线程是谁?

1. 是主线程中第一次调用executorService.execute让线程池执行任务的时候,线程池发现当前线程数小于核心线程数,所以会创建一个线程

2. 他的父线程是谁?是创建他的线程,也就是执行第一次执行executorService.execute的线程,即主线程

-----------------------------------------------------------------------------------------------------

子线程创建的时候,子线程会将父线程中InheritableThreadLocal的值复制一份到子线程的InheritableThreadLocal中

从上面代码中可以看到,父线程InheritableThreadLocal中第一次丢入的是张三,之后就调用线程池的execute方法执行任务

此时,会在线程池中创建子线程,这个子线程会将父线程中InheritableThreadLocal中设置的张三

复制到子线程的InheritableThreadLocal中,此时子线程中的用户名就是从父线程复制过来的,即:张三

-----------------------------------------------------------------------------------------------------

复制之后,父子线程中的InheritableThreadLocal就没有关系了,父线程中InheritableThreadLocal的值再修改

也不会影响子线程中的值了,所以两次输出的都是张三

d.存在的问题

InheritableThreadLocal 用在线程池上,会有问题,可能导致严重事故,这个一定要知道。

如何解决这个问题呢?

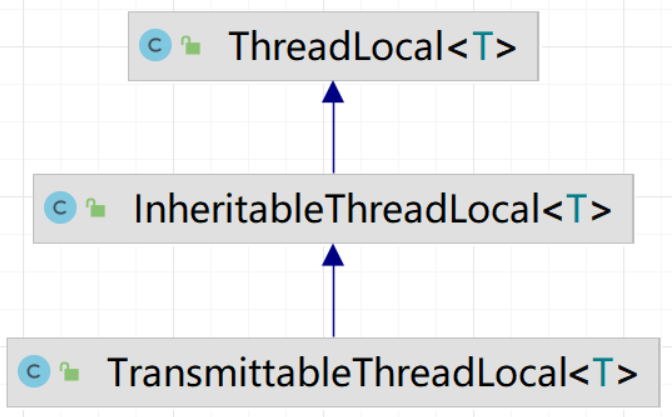

阿里的:TransmittableThreadLocal,这个就是为解决这个问题而来的。

05.案例5:TransmittableThreadLocal:解决线程池中不能够访问外部线程数据的问题

a.依赖

<dependency>

<groupId>com.alibaba</groupId>

<artifactId>transmittable-thread-local</artifactId>

<version>2.14.3</version>

</dependency>

b.说明

使用 TransmittableThreadLocal 代替 InheritableThreadLocal 和 ThreadLocal

线程池需要用 TtlExecutors.getTtlExecutorService 包裹一下,这个一定不要漏掉

ExecutorService executorService = TtlExecutors.getTtlExecutorService(Executors.newFixedThreadPool(1));

c.示例代码

TransmittableThreadLocal<String> userNameTtl = new TransmittableThreadLocal<String>();

@Test

public void transmittableThreadLocal1() throws InterruptedException {

//为了看到效果,这里创建大小为1的线程池,注意这里为1才能方便看到效果

ExecutorService executorService = Executors.newFixedThreadPool(1);

//这里需要用 TtlExecutors.getTtlExecutorService 将原线程池包装下

executorService = TtlExecutors.getTtlExecutorService(executorService);

// 主线程中设置 张三

userNameTtl.set("张三");

logger.info("userName:{}", userNameTtl.get());

//在线程池中通过 TransmittableThreadLocal 拿值,看看能否拿到 刚才放入的张三?

executorService.execute(() -> {

logger.info("第1次获取 userName:{}", userNameTtl.get());

});

TimeUnit.SECONDS.sleep(1);

//这里放入了李四

userNameTtl.set("李四");

logger.info("userName:{}", userNameTtl.get());

//在线程池中通过 TransmittableThreadLocal 拿值,看看能否拿到 刚才放入的李四?

executorService.execute(() -> {

//在线程池中通过 inheritableThreadLocal 拿值,看看能否拿到?

logger.info("第2次获取 userName:{}", userNameTtl.get());

});

TimeUnit.SECONDS.sleep(1);

}

d.执行输出

20:02:28 [main] transmittableThreadLocal1 - userName:张三

20:02:28 [pool-1-thread-1] lambda$transmittableThreadLocal1$6 - 第1次获取 userName:张三

20:02:29 [main] transmittableThreadLocal1 - userName:李四

20:02:29 [pool-1-thread-1] lambda$transmittableThreadLocal1$7 - 第2次获取 userName:李四

2.9 通过AOP统一打印请求链路日志

01.思考一个问题:当一个接口报错的时候,如何能够快速定位问题?

如果能够满足下面这些条件,咱们就可以快速定位错误

1.能够快速找到接口的详细调用日志

2.日志中最好知道出错的是哪个接口的哪个方法,即哪个controller的哪个方法

3.日志中最好有接口的入参、返参

4.日志中含有异常的详细堆栈信息(即:哪行代码报的错)

02.代码实战

a.启动案例

com.itsoku.lesson019.Lesson019Application

b.访问一个正常的接口

http://localhost:8080/userAdd?userName=路人&age=35&password=123456

c.先看下接口的返回值,里面有个traceId

{

"success": true,

"data": true,

"msg": null,

"code": null,

"traceId": "b910649f02514cae8b015a862c7f6dca"

}

d.拿着这个traceId的值,可以找到这个请求完整的日志

看后端控制台,通过traceId的值去检索

如下,可以看到接口的详细执行日志

包含(接口url、开始时间、结束时间、及处理这个请求的controller和方法、还有方法的入参、返回值,都输出了)

前端给我们这个traceId,我们便可以快速定位到这个请求的完整调用日志

e.再来看请求一个异常的接口,浏览器中打开下面地址

http://localhost:8080/login?name=张三

f.浏览器中显示如下,可以看出接口报错了

{

"success": false,

"data": null,

"msg": "用户名无效",

"code": null,

"traceId": "a3b2d88c85134e5dad4d3d7ccd8cd892"

}

g.可以拿着上面的traceId的值,去后端控制台找对应的日志

[traceId:9e0dcfad49064c99a5913b3bec61cfaa] 请求start:http://localhost:8080/loqin

[traceId:a3b2d88c85134e5dad4d3d7ccd8cd892] 接口方法:com.itsoku.lesson019.controller.UserController.login

[traceId:a3b2d88c85134e5dad4d3d7ccd8cd892] 方法参数列表:{"name":"张三"}

[traceId:a3b2d88c85134e5dad4d3d7ccd8cd892] 方法返回值:nutl

[traceId:a3b2d88c85134e5dad4d3d7ccd8cd892] 请求:http://Localhost:8080/Loqin,发生异常:用户名无效

[traceId:a3b2d88c85134e5dad4d3d7ccd8cd892] com.itsoku.lesson019.common.BusinessExceptionCreatebreakpoint:用户名无效

[traceId:a3b2d88c85134e5dad4d3d7ccd8cd892] at com.itsoku.lesson019.common.BusinessExceptionUtils.businessException(BusinessExceptionUtils.iava:16)

[traceId:a3b2d88c85134e5dad4d3d7ccd8cd892] 请求end:http://Localhost:8080/Loqin,耗时(ms):3

03.源码解析

a.ControllerLogAspect

打印接口的详细日志

b.TraceFilter

生成唯一的traceId,日志中会输出这个tracId

c.ResultTraceIdAspect

将traceId统一丢到响应结果Result类的traceId字段中

2.10 大批量任务处理常见方案

00.开头说的还有一些需求我们没有考虑到

a.收益不能重复发送,这个如何解决?

也就是发送的逻辑需要幂等,对谁做幂等?(userId+当天的日期),即每个用户当天不能重发幂等的解决方案

b.对于每天发放的结果需要进行汇报(发放人数、成功人数、失败人数、还未发放的人数),这个如何搞呢?

可以创建一张收益发放记录表(t_user_profit),字段如下,通过这个表就可以统计到上面要的信息

userId:用户id

day:发放日期,格式:YYYYMMDD,比如:20240414

status:状态,0:未发放,1:已发放,2:发放失败

fail_reason:发放失败的原因

create_time:创建时间

c.那这个表如何使用呢?

在job中分发MQ消息的时候,同时向这个表中插入对应的记录,也就是每天要写入1亿条记录,这个地方可能有性能瓶颈,建议压测下

如果感觉太慢,可以分表,按天分表,每天一张表,这样这个表就只有一个亿的数据了

如果还是感觉慢,分表字段可以使用:日期+userId,每个日期开100个表,然后根据userId再进行路由

d.发放逻辑中需要调整下

1.收益发放成功修改这条记录的状态

2.收益发放失败也需要修改状态,并记录失败原因

e.发放逻辑可以考虑失败做一些重试

发放的逻辑中,对于失败的情况,可以稍微休眠会,然后重试,比如重试3次,这样可最大程度使其成功

f.提供一个运营后台

最好能够提供一个后台,看到每天发放的情况,如(发放人数、成功人数、失败人数、还未发放的人数、总金额等)

对于发放失败的,支持手动点击按钮进行重试

01.场景

假如余额宝每天发放收益的功能让咱们来实现,用户量有1个亿,每天早上9点之前需要将发放完毕,咱们会采用什么方案呢?

下面我们会采用2种方法来实现,以后遇到同类问题的时候,大家可以作为参考

02.需求分析

1.这用户量相当大,有1个亿

2.当天的收益要在 9 点之前发放完毕,也就是说,如果从零点开始执行,中间有 9 个小时来处理这个业务

3.用户的收益不能出现重复发送的情况

4.对于每天发放的结果需要进行汇报(发放人数、成功人数、失败人数、还未发放的人数、总金额)

5.最好有个后台可以看到这些统计信息,并支持对失败的进行手动补偿

03.方案1:使用job+线程池去跑

a.原理

step1:拉取待处理的数据,比如拉取10000条记录

step2:交给线程池去去处理,比如线程池的大小是100

step3:等待step2中的批处理结束

step4:回到step1,继续拉取用户进行处理,如果step1中发现已经没有用户需要处理了,则直接退出。

b.这个方法有没有问题?

我们假设每次发放收益需要耗时1秒,我们来算一下,1亿用户跑完需要多久

1亿/100个线程/24小时/每小时是3600秒 = 100000000/100/24/3600 = 如下 ≈ 11.57 天左右。

这个结果完全是无法接受的,那么有些朋友说可以将100个线程开到1000个,但是这样也需要1.15天啊,也无法满足需求

有些同学说,可以将线程池开到1万个,那么就只需要0.115天了,大家可以试试,单台机器跑1万个线程,会是什么个情况,大多数机器都是扛不住的,即使能抗住,数据库也是扛不住的。

如果用户量比较少,比如100万以内的用户,用这种方式可以搞定。

c.有没有更好的办法?

一台机器搞不定这个问题,那么我们可以搞个100台机器,目前使用云来扩展机器还是很容易的。

如果换成100台机器来同时干这个事情,每个机器负责跑100万用户,这个问题就解决了。

但是如何让100台机器同时来干这个事情呢?看方案2

04.方案2:使用集群+MQ来解决

a.说明

需要有一台机器来分发任务,将1个亿的用户转换成1亿条消息丢到MQ中,然后下面有100台机器从MQ中拉取这些消息去消费

b.需要有个job来做任务分发

job从db中分多批拉出1亿用户,每个用户生成一条MQ消息,投递到MQ中,差不多1个亿的消息

如果这里感觉消息太多,那么一条消息中也可以放10个或者100个用户

这里投递MQ消息也可以使用线程池来进行投递,提升速度

c.MQ消费者集群

这里我们会将发放收益的服务,部署100个,每个服务中开100个消费者从MQ中拉取消息,相当于同时有10000个消费者同时消费消息

d.这种方式耗时多久?我们来估算下

1.发送1亿条消息,预估0.5小时

2.1亿条消息,交给1万个消费者,这样每个消费者消费1万个,每个耗时1秒,也就是1万秒 = 3小时左右,预计耗时 3.5 个小时,达到了预期

3 part02

3.1 判断代码在并发情况下会否安全

00.背景

a.说明

1.比如我们写了个扣库存的方法,怎么知道此方法在并发情况下,是否会超卖?

2.或者其他一些类似的业务操作,怎么知道他们在并发的情况下,有没有问题?

这种问题统称为:在并发情况下,如何确定咱们的代码是否和预期的一致